Inteligencia Artificial

Sam Altman vaticina una IA que resuelva tareas del mundo real por nosotros

El CEO de Open AI afirma que no necesitaremos nuevo hardware ni muchos más datos de entrenamiento para conseguirlo.

Varios momentos de mi breve entrevista con Sam Altman pusieron de manifiesto la visión del mundo del CEO de OpenAI. El primero fue cuando señaló mi iPhone SE (el del botón de inicio que casi todos odian) y dijo: "Es el mejor iPhone". Sin embargo, lo más revelador fue la visión que esbozó de cómo las herramientas de inteligencia artificial se integrarán en nuestra vida cotidiana aún más que el smartphone.

"Lo que realmente quieres", dijo a MIT Technology Review, "es una cosa quete ayude desde fuera". Altman, que estaba de visita en Cambridge para una serie de actos organizados por Harvard y la empresa de capital riesgo Xfund, describió la aplicación estrella de la IA como un "compañero supercompetente que sepa absolutamente todo sobre toda mi vida, cada correo electrónico, cada conversación que he tenido, pero que no se sienta como una extensión". Podría abordar algunas tareas al instante, dijo, y para las más complejas podría ir y hacer un intento, pero volver con preguntas para usted si es necesario.

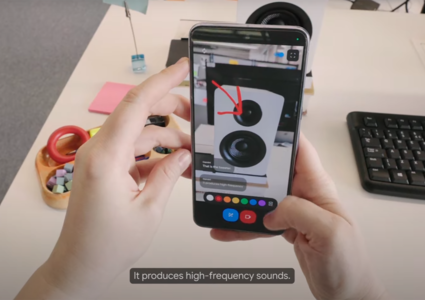

Es un salto con respecto a la oferta actual de OpenAI. Sus principales aplicaciones, como Dall-E, Sora y ChatGPT (a las que Altman se refirió como "increíblemente tontas" en comparación con lo que está por venir), nos han asombrado con su capacidad para generar textos convincentes y vídeos e imágenes surrealistas. Pero en su mayoría siguen siendo herramientas que utilizamos para tareas aisladas, y tienen una capacidad limitada para aprender sobre nosotros a partir de nuestras conversaciones con ellos.

En el nuevo paradigma, tal y como lo ve Altman, la IA será capaz de ayudarnos fuera de la interfaz de chat y de quitarnos de encima tareas del mundo real.

Altman sobre el futuro del hardware de IA

Le pregunté a Altman si necesitaremos un nuevo hardware para llegar a este futuro. Aunque los smartphones son extraordinariamente capaces y sus diseñadores ya están incorporando más funciones basadas en la IA, algunos empresarios apuestan por que la IA del futuro requerirá un dispositivo más diseñado para este fin. Algunos de estos dispositivos ya están empezando a aparecer en su órbita. Por ejemplo, está el (muy criticado) AI Pin de Humane (Altman es inversor en la empresa, pero no ha sido precisamente un defensor del dispositivo), que se puede llevar como un accesorio. También se rumorea que está trabajando con el ex diseñador de Apple Jony Ive en un nuevo tipo de hardware.

Pero Altman dice que existe la posibilidad de que no necesitemos necesariamente un dispositivo. "No creo que se necesite un nuevo hardware", me dijo, añadiendo que el tipo de aplicación prevista podría existir en la nube. Pero rápidamente añadió que, aunque este cambio de paradigma de la IA no requiera que los consumidores compren un nuevo hardware, "creo que se alegrarán de tenerlo [un nuevo dispositivo]".

Aunque Altman opina que los dispositivos de hardware de IA son apasionantes, también dio a entender que quizá no sea el más adecuado para asumir el reto él mismo: "Estoy muy interesado en el hardware de consumo para nuevas tecnologías. Soy un aficionado al que le encanta, pero esto está muy lejos de mis conocimientos".

A la caza de datos de entrenamiento

Al escuchar su visión de potentes agentes impulsados por IA, me pregunté cómo encajaría con la actual escasez de datos de entrenamiento del sector. Para crear GPT-4 y otros modelos, OpenAI ha rastreado archivos de Internet, periódicos y blogs en busca de datos de entrenamiento, ya que las leyes de escalado llevan tiempo demostrando que hacer modelos más grandes también los hace mejores. Pero encontrar más datos para entrenar es un problema cada vez mayor. Gran parte de la información en Internet ya ha sido absorbida, y el acceso a datos privados o protegidos por derechos de autor está inmerso en batallas legales.

Altman es optimista y cree que esto no será un problema durante mucho más tiempo, aunque no ha concretado los detalles.

"Creo, aunque no estoy seguro, que vamos a encontrar una salida a este problema de que siempre se necesitan más y más datos de entrenamiento", afirma. "Los humanos son la prueba de existencia de que hay otra forma de [entrenar la inteligencia]. Y espero que la encontremos".

Sobre quién estará preparado para crear la AGI

La visión central de OpenAI gira desde hace tiempo en torno a la búsqueda de la inteligencia artificial general (IAG), es decir, una IA capaz de razonar tan bien o mejor que los humanos. Su misión declarada es garantizar que una tecnología así "beneficie a toda la humanidad". Sin embargo, no es ni mucho menos la única empresa que persigue la AGI. En la carrera hacia la inteligencia artificial, ¿cuáles son las herramientas más importantes? Le pregunté a Altman si cree que la entidad que reúna la mayor cantidad de chips y potencia de cálculo será finalmente la ganadora.

Altman sospecha que habrá "varias versiones diferentes [de AGI] que sean mejores y peores en cosas diferentes", afirma. "Supongo que habrá que superar algún umbral de computación. Pero ni siquiera entonces diría que estoy seguro".

Sobre cuándo veremos la GPT-5

¿Creías que respondería a eso? Cuando otro periodista de la sala preguntó a Altman si sabía cuándo está previsto que salga al mercado la próxima versión de GPT, dio una respuesta tranquila. "Sí", respondió sonriendo, y no dijo nada más.