Inteligencia Artificial

El futuro del vídeo generativo: del riesgo de los ‘deepfakes’ al jaque a Hollywood

Sora, de OpenAI, ha subido el listón de la producción cinematográfica con IA. Aquí tienes cuatro cosas que debes tener en cuenta mientras te preparas para lo que viene

La serie ‘What's Next’ de ‘MIT Technology Review’ analiza distintos sectores, tendencias y tecnologías para ofrecerte una visión anticipada del futuro. Puedes leer el resto aquí.

Cuando OpenAI presentó su nuevo modelo de vídeo generativo, Sora, el mes pasado, invitó a un puñado de cineastas a probarlo. Esta semana, la empresa ha publicado los resultados: siete cortometrajes surrealistas que no dejan lugar a dudas de que el futuro del vídeo generativo está al caer.

El primer lote de modelos capaces de convertir texto en vídeo apareció a finales de 2022, de la mano de empresas como Meta, Google y la startup de tecnología de vídeo Runway. Era un truco ingenioso, pero los resultados eran granulados, con fallos y de apenas unos segundos de duración.

Han pasado 18 meses, y lo mejor de la producción fotorrealista de alta definición de Sora es tan asombroso que algunos observadores están prediciendo la muerte de Hollywood. Los últimos modelos de Runway pueden producir clips cortos que rivalizan con los de los estudios de animación más taquilleros. Midjourney y Stability AI, las empresas que están detrás de dos de los modelos más populares de conversión de texto en imagen, trabajan ahora también en vídeo.

Varias empresas se están apresurando a crear un negocio a partir de estos avances. La mayoría van descubriendo cuál es ese negocio sobre la marcha. "Cuando juego con estas herramientas, suelo gritar 'Madre mía, qué pasada'", dice Gary Lipkowitz,CEO de Vyond, una empresa que ofrece una plataforma point-and-click para crear vídeos animados cortos. "Pero, ¿cómo se puede utilizar esto en el trabajo?".

Sea cual sea la respuesta a esa pregunta, probablemente pondrá patas arriba un amplio abanico de negocios y cambiará las funciones de muchos profesionales, desde animadores a publicistas. También crece el temor al uso indebido. La capacidad generalizada de generar vídeos falsos hará más fácil que nunca inundar internet de propaganda y pornografía no consentida. Lo estamos viendo venir. El problema es que nadie tiene una buena solución.

Mientras nos preparamos para lo que nos espera —bueno y malo—, aquí tienes cuatro cosas en las que pensar. También hemos recopilado una selección de los mejores vídeos realizados por cineastas con esta tecnología, incluida la presentación en exclusiva de Somme Requiem, un cortometraje experimental de la productora Myles, con sede en Los Ángeles. Sigue leyendo y descubre hacia dónde se dirige el cine con IA.

1. Sora es solo el principio

Sora, de OpenAI, está actualmente muy por encima de la competencia en la generación de vídeo. Pero otras empresas están trabajando duro para ponerse a su altura. El mercado se va a saturar en los próximos meses, a medida que más empresas perfeccionen su tecnología y empiecen a lanzar rivales de Sora.

La empresa británica Haiper ha salido del anonimato este mes. Fue fundada en 2021 por antiguos investigadores de Google DeepMind y TikTok que querían trabajar en una tecnología llamada campos de radiancia neural, o NeRF (por sus siglas en inglés), que puede transformar imágenes 2D en entornos virtuales 3D. Pensaron que una herramienta que convirtiera instantáneas en escenas en las que los usuarios pudieran adentrarse sería útil para crear videojuegos.

Pero hace seis meses, Haiper pasó de los entornos virtuales a los videoclips, adaptando su tecnología a lo que su CEO, Yishu Miao, cree que será un mercado aún mayor que el de los videojuegos. "Nos dimos cuenta de que la generación de vídeo era la clave", dice Miao. "Habrá una demanda súper alta".

Al igual que Sora de OpenAI, la tecnología de vídeo generativo de Haiper utiliza un modelo de difusión para gestionar los efectos visuales y un transformador (el componente de los modelos de lenguaje de gran tamaño como GPT-4 que los hace tan buenos a la hora de predecir lo que viene a continuación), para gestionar la coherencia entre fotogramas. "Los vídeos son secuencias de datos, y los transformadores son el mejor modelo para aprender secuencias", explica Miao.

La coherencia es un gran reto para el vídeo generativo y la principal razón por la que las herramientas actuales producen solo unos segundos de vídeo cada vez. Los transformadores para la generación de vídeo pueden aumentar la calidad y la duración de los clips. El inconveniente es que los transformadores inventan cosas, o tienen alucinaciones. En texto, esto no siempre es obvio. En vídeo, el resultado puede ser, por ejemplo, una persona con varias cabezas. Para mantener a los transformadores en el buen camino se necesitan grandes silos de datos de entrenamiento y almacenes llenos de ordenadores.

Por eso Irreverent Labs, fundada por antiguos investigadores de Microsoft, está adoptando un enfoque diferente. Al igual que Haiper, Irreverent Labs empezó generando entornos para juegos antes de pasar a la generación completa de vídeo. Pero la empresa no quiere seguir al rebaño copiando lo que hacen OpenAI y otros. "Porque entonces es una batalla de computación, una guerra total de GPU [procesadores gráficos, por sus siglas en inglés]", dice David Raskino, cofundador y CTO de Irreverent. "Y en ese escenario solo hay un ganador, y lleva una chaqueta de cuero". (Se refiere a Jensen Huang, CEO del gigante del chip Nvidia, valorado en un billón de dólares).

En lugar de utilizar un transformador, la tecnología de Irreverent combina un modelo de difusión con un modelo que predice lo que hay en el fotograma siguiente basándose en la física del sentido común, por ejemplo, cómo rebota una pelota o cómo salpica el agua en el suelo. Raskino afirma que este enfoque reduce tanto los costes de entrenamiento como el número de alucinaciones. El modelo sigue produciendo fallos, pero son distorsiones de la física (como una pelota que rebota y no sigue una curva suave, por ejemplo) con correcciones matemáticas conocidas que pueden aplicarse al vídeo una vez generado, dice.

Queda por ver qué método perdurará. Miao compara la tecnología actual con los modelos lingüísticos de gran tamaño en torno a la época de GPT-2. Hace cinco años, el innovador modelo inicial de OpenAI asombró a la gente porque mostraba lo que era posible. Pero tuvieron que pasar varios años para que la tecnología cambiara las reglas del juego.

Lo mismo ocurre con el vídeo, dice Miao: "Estamos al pie de la montaña".

2. ¿Qué hará la gente con el vídeo generativo?

El vídeo es el medio de internet. YouTube, TikTok, noticieros, anuncios: es de esperar que el vídeo sintético aparezca en todos los sitios donde ya hay vídeo.

El sector del marketing es uno de los más entusiastas a la hora de adoptar la tecnología generativa. Dos tercios de los profesionales del marketing han experimentado con la IA generativa en su trabajo, según una encuesta reciente realizada por Adobe en Estados Unidos, y más de la mitad afirman haber utilizado esta tecnología para producir imágenes.

El vídeo generativo es lo siguiente. Algunas empresas de marketing ya han creado cortometrajes para demostrar el potencial de esta tecnología. El último ejemplo es Somme Requiem, de 2,5 minutos de duración, realizado por Myles. Puedes ver la película a continuación en una exclusiva de MIT Technology Review.

Somme Requiem muestra a soldados atrapados por la nieve durante el alto el fuego navideño de la Primera Guerra Mundial en 1914. La película se compone de docenas de tomas diferentes que se produjeron utilizando un modelo de vídeo generativo de Runway; después, editores de vídeo humanos de Myles las unieron, realizaron la corrección de color y añadieron música. "El futuro de la narración será un flujo de trabajo híbrido", afirma su fundador y CEO, Josh Kahn.

Kahn eligió la ambientación bélica para dejar clara una idea. Señala que la serie de Apple TV+ Masters of the Air, que sigue a un grupo de aviadores de la Segunda Guerra Mundial, costó 250 millones de dólares (unos 230 millones de euros). El equipo detrás del documental de Peter Jackson sobre la Primera Guerra Mundial, They Shall Not Grow Old, pasó cuatro años recopilando y restaurando más de 100 horas de películas de archivo. "La mayoría de los cineastas solo pueden soñar con tener la oportunidad de contar una historia de este género", dice Kahn.

"El cine independiente está muriendo", añade. "Creo que esto creará un resurgimiento increíble".

Raskino espera que así sea. "El género del cine de terror es donde la gente prueba cosas nuevas para intentar cosas innovadoras hasta que triunfan", dice. "Creo que vamos a ver una película de terror taquillera creada por cuatro personas en un sótano en algún lugar usando IA".

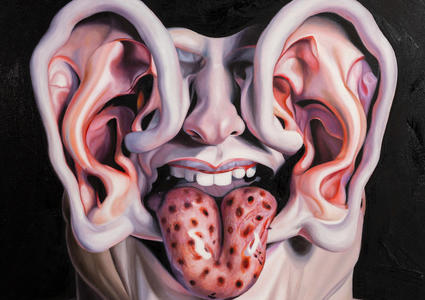

¿Es el vídeo generativo el asesino de Hollywood? Todavía no. Los planos de establecimiento de Somme Requiem —bosques vacíos, un campo militar desolado— son fantásticas. Pero las personas que aparecen en ellas siguen teniendo los dedos destrozados y los rostros distorsionados, rasgos distintivos de la tecnología. El vídeo generativo funciona mejor con panorámicas gran angular o primeros planos prolongados, que crean una atmósfera inquietante pero poca acción. Si Somme Requiem fuera más larga, resultaría aburrida.

Sin embargo, los planos de establecimiento abundan en los largometrajes. La mayoría duran solo unos segundos, pero su rodaje puede llevar horas. Raskino sugiere que pronto podrían utilizarse modelos de vídeo generativo para producir esas tomas intermedias por una fracción del coste. Esto también podría hacerse sobre la marcha en fases posteriores de la producción, sin necesidad de volver a rodar.

Michal Pechoucek, director de tecnología de Gen Digital, el gigante de la ciberseguridad detrás de una serie de marcas de antivirus como Norton y Avast, está de acuerdo. "Creo que hacia aquí se dirige la tecnología", afirma. "Veremos muchos modelos diferentes, cada uno de ellos formado específicamente en un determinado ámbito de la producción cinematográfica. Solo serán herramientas utilizadas por equipos de producción de vídeo con talento".

Aún no hemos llegado a ese punto. Un gran problema del vídeo generativo es la falta de control de los usuarios sobre el resultado. Producir imágenes fijas puede ser una prueba y error; producir unos segundos de vídeo es aún más arriesgado.

"Ahora mismo sigue siendo divertido, se consiguen momentos 'ja, ja'", dice Miao. "Pero generar un vídeo que sea exactamente lo que quieres es un problema técnico muy difícil. Estamos muy lejos de generar vídeos largos y coherentes a partir de una sola indicación".

Por eso Lipkowitz, de Vyond, cree que la tecnología aún no está preparada para la mayoría de los clientes corporativos. Estos usuarios quieren mucho más control sobre el aspecto de un vídeo del que les ofrecen las herramientas actuales, afirma.

Miles de empresas de todo el mundo, entre ellas el 65% de las que figuran en la lista Fortune 500, utilizan la plataforma de Vyond para crear vídeos animados con fines de comunicación interna, formación, marketing y otros. Vyond se basa en una serie de modelos generativos, como texto a imagen y texto a voz, pero ofrece una sencilla interfaz de arrastrar y soltar que permite a los usuarios montar un vídeo a mano, pieza a pieza, en lugar de generar un clip completo con un clic.

Ejecutar un modelo generativo es como tirar los dados, dice Lipkowitz. "Es un ‘no’ rotundo para la mayoría de los equipos de producción de vídeo, sobre todo en el sector empresarial, donde todo debe ser perfecto y acorde con la marca", afirma. "Si el vídeo sale mal —quizá los personajes tienen demasiados dedos, o quizá hay un logotipo de la empresa que no es del color adecuado—, pues mala suerte, así es como funciona la IA generativa".

¿La solución? Más datos, más entrenamiento, repetir. "Ojalá pudiera señalar algún algoritmo sofisticado", dice Miao. "Pero no, es solo mucho más aprendizaje".

3. La desinformación no es nueva, pero los deepfakes la empeorarán

La desinformación online lleva años minando nuestra fe en los medios, en las instituciones y en los demás. Algunos temen que añadir vídeos falsos a la mezcla destruirá los pilares de realidad compartida que nos quedan.

"Estamos sustituyendo la confianza por la desconfianza, la confusión, el miedo y el odio", afirma Pechoucek. "La sociedad sin verdad fundamental degenerará".

A Pechoucek le preocupa especialmente el uso malintencionado de deepfakes en las elecciones. Durante las elecciones del año pasado en Eslovaquia, por ejemplo, unos atacantes compartieron un vídeo falso que mostraba al candidato principal discutiendo planes para manipular a los votantes. El vídeo era de baja calidad y fácil de detectar como deepfake. Pero Pechoucek cree que fue suficiente para decantar el resultado a favor del otro candidato.

John Wissinger, que dirige los equipos de estrategia e innovación de Blackbird AI, una empresa que rastrea y gestiona la difusión de desinformación en internet, cree que los vídeos falsos serán más persuasivos cuando mezclen imágenes reales y falsas. Tomemos dos vídeos en los que se ve al Presidente Joe Biden caminando por un escenario. En uno tropieza, en el otro no. ¿Quién puede decir cuál es real?

"Digamos que un acontecimiento ocurrió realmente, pero la forma en que se me presenta es sutilmente diferente", dice Wissinger. "Eso puede afectar a mi respuesta emocional ante él". Como señala Pechoucek, un vídeo falso ni siquiera tiene que ser demasiado bueno para causar impacto. Una mala falsificación que se ajuste a los prejuicios existentes hará más daño que una falsificación hábil que no lo haga, dice Wissinger.

Por eso Blackbird se centra en quién comparte qué con quién. En cierto sentido, que algo sea cierto o falso es menos importante que de dónde procede y cómo se difunde, afirma Wissinger. Su empresa ya rastrea la desinformación de bajo nivel tecnológico, como las publicaciones en redes sociales que muestran imágenes reales fuera de contexto. Las tecnologías generativas empeoran las cosas, pero el problema de la gente que presenta contenido de forma engañosa, deliberadamente o no, no es nuevo, afirma.

Si añadimos los bots, que comparten y promueven la desinformación en las redes sociales, la cosa se complica. El mero hecho de saber que existen medios falsos sembrará la duda en el discurso de mala fe. "Pronto será imposible discernir entre lo que es sintético y lo que es real", dice Wissinger.

4. Nos enfrentamos a una nueva realidad en línea

Pronto habrá falsificaciones por todas partes, desde campañas de desinformación a anuncios publicitarios o superproducciones de Hollywood. Entonces, ¿qué podemos hacer para saber qué es real y qué es pura fantasía? Hay una serie de soluciones, pero ninguna funcionará por sí sola.

La industria tecnológica está trabajando en el problema. La mayoría de las herramientas generativas intentan imponer ciertas condiciones de uso, como impedir que se creen vídeos de personajes públicos. Pero hay formas de saltarse estos filtros, y las versiones de código abierto de las herramientas pueden venir con políticas más permisivas.

Las empresas también están desarrollando normas para poner marcas de agua a los medios generados por IA y herramientas para detectarlas. Pero no todas las herramientas añaden marcas de agua, y estas pueden eliminarse de los metadatos de un vídeo. Tampoco existe ninguna herramienta de detección fiable. Incluso si estas herramientas funcionaran, formarían parte de un juego del gato y el ratón para tratar de mantenerse al día con los avances en los modelos que están diseñadas para vigilar.

Las plataformas en línea como X y Facebook no tienen un buen historial en lo que respecta a la moderación. No deberíamos esperar que lo hagan mejor cuando el problema se complique. Miao solía trabajar en TikTok, donde ayudó a crear una herramienta de moderación que detecta las subidas de vídeos que infringen las condiciones de uso de TikTok. Incluso él desconfía de lo que se avecina: "Hay un peligro real ahí fuera", dice. "No te fíes de las cosas que ves en tu portátil".

Blackbird ha desarrollado una herramienta llamada Compass, que permite comprobar artículos y publicaciones en redes sociales. Pega un enlace en la herramienta y un modelo lingüístico de gran tamaño genera una reseña extraída de fuentes en línea de confianza (estas siempre están abiertas a revisión, dice Wissinger) que aporta algo de contexto al material enlazado. El resultado es muy similar a las notas de la comunidad que a veces se adjuntan a las publicaciones controvertidas en sitios como X, Facebook e Instagram. La empresa prevé que Compass genere notas comunitarias para cualquier cosa. "Estamos trabajando en ello", dice Wissinger.

Pero la gente que pone enlaces en un sitio web de comprobación de hechos ya es bastante espabilada, y puede que muchos otros no sepan que existen estas herramientas, o no estén dispuestos a confiar en ellas. La desinformación también tiende a viajar mucho más lejos que cualquier corrección posterior.

Mientras tanto, no se sabe de quién es el problema. Pechoucek afirma que las empresas tecnológicas deben abrir su software para permitir una mayor competencia en torno a la seguridad y la confianza. Eso también permitiría a empresas de ciberseguridad como la suya desarrollar software de terceros para vigilar esta tecnología. Es lo que ocurrió hace 30 años, cuando Windows tuvo un problema de malware: "Microsoft dejó que las empresas antivirus ayudaran a proteger Windows. Como resultado, el mundo online se convirtió en un lugar más seguro".

Pero Pechoucek no es demasiado optimista. "Los desarrolladores de tecnología tienen que crear sus herramientas con la seguridad como principal objetivo", afirma. "Pero hay más gente que piensa en cómo hacer más potente la tecnología que en preocuparse por cómo hacerla más segura".

Hay un dicho fatalista muy común en la industria tecnológica: el cambio se avecina, asúmelo. "La IA generativa no se va a desinventar", dice Raskino. "Puede que esto no sea muy popular, pero creo que es cierto: no creo que las empresas tecnológicas puedan asumir toda la carga. Al fin y al cabo, la mejor defensa contra cualquier tecnología es un público muy bien educado. No hay atajos".

Miao está de acuerdo. "Es inevitable que adoptemos masivamente la tecnología generativa", afirma. "Pero también es responsabilidad de toda la sociedad. Tenemos que educar a la gente".

"La tecnología avanzará, y tenemos que estar preparados para este cambio", añade. "Tenemos que recordar a nuestros padres, a nuestros amigos, que las cosas que ven en su pantalla pueden no ser auténticas". Esto es especialmente cierto para las generaciones mayores, dice: "Nuestros padres tienen que ser conscientes de este tipo de peligro. Creo que todos debemos trabajar juntos".

Tendremos que trabajar juntos rápidamente. Cuando Sora salió hace un mes, el mundo de la tecnología se quedó atónito por lo rápido que había progresado el vídeo generativo. Pero la inmensa mayoría de la gente no tiene ni idea de que existe este tipo de tecnología, dice Wissinger: "Desde luego, no entienden la tendencia en la que estamos. Creo que va a tomar al mundo por sorpresa".