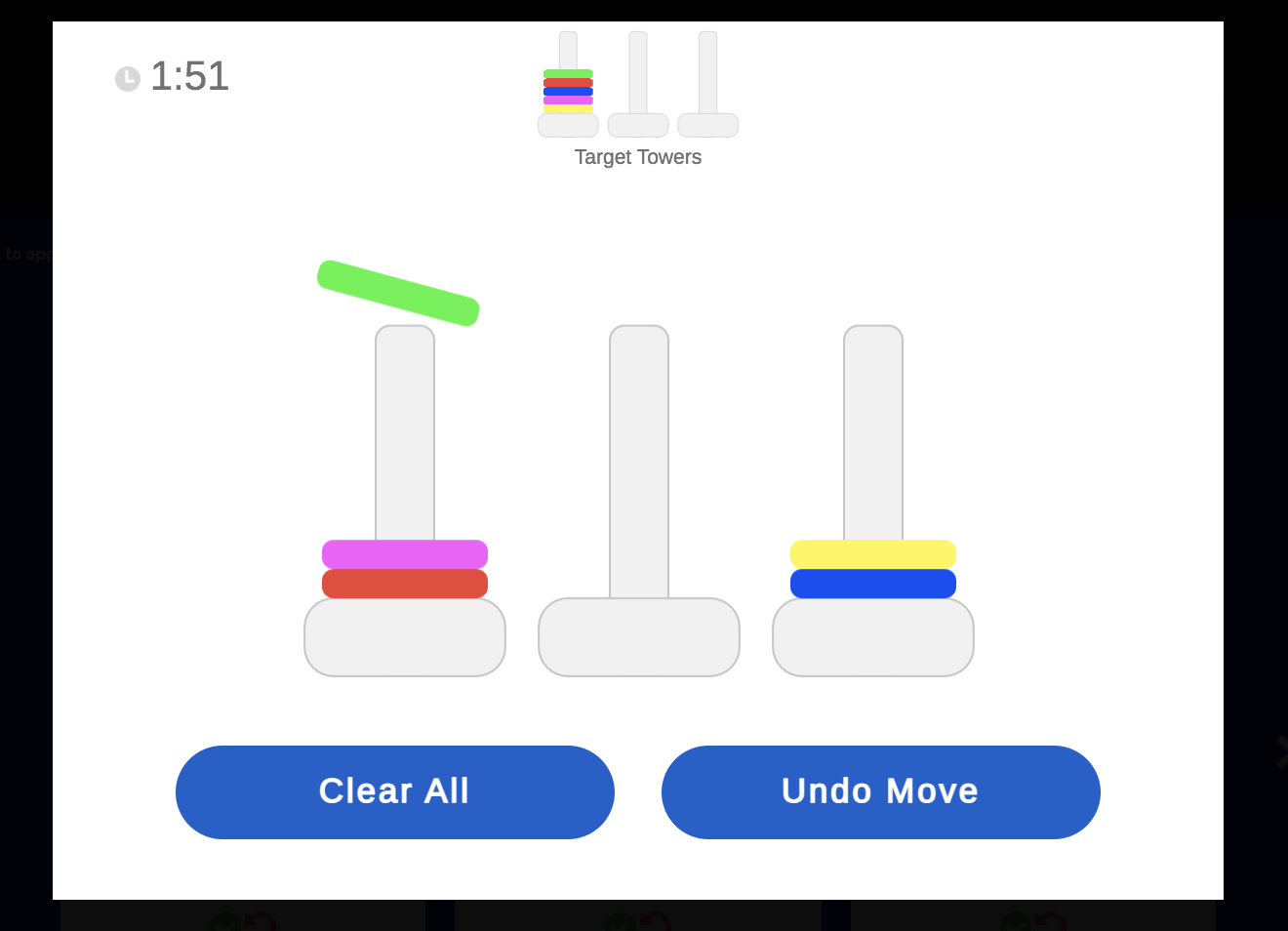

Estoy en casa jugando a un videojuego que consiste en inflar globos uno a uno para ganar la mayor cantidad de dinero posible. Cada vez que hago clic en «Inflar», el globo se expande y recibo cinco centavos virtuales. Pero si el globo explota antes de que pulse el botón de «Cobrar», todas mis ganancias digitales desaparecen.

Tras inflar 39 globos, gané unos 12 euros y apareció un mensaje en la pantalla que decía: «Usted mantiene un enfoque coherente en situaciones de alto riesgo. La característica medida: tolerancia al riesgo».

Este juego forma parte de un conjunto creado por la compañía Pymetrics, que muchas grandes empresas estadounidenses están utilizando para seleccionar a candidatos para sus puestos de trabajo. Si alguien se postula a un trabajo en McDonald’s, Boston Consulting Group, Kraft Heinz o Colgate-Palmolive, es posible que se le pida que juegue a los juegos de Pymetrics.

Mientras juego, un sistema de inteligencia artificial (IA) mide distintos rasgos como la generosidad, la honestidad y la atención. Si realmente estuviera solicitando un puesto, el sistema compararía mis puntuaciones con las de los empleados que ya trabajan en ese puesto. Si mi perfil de personalidad reflejara los rasgos más específicos de las personas que tienen éxito en ese puesto, pasaría a la siguiente etapa de contratación.

Cada vez más empresas utilizan herramientas de contratación basadas en inteligencia artificial como estas para gestionar la avalancha de solicitudes que reciben, especialmente ahora que hay aproximadamente el doble de trabajadores desempleados en Estados Unidos que antes de la pandemia. Una encuesta de más de 7.300 responsables de recursos humanos en todo el mundo, realizada por la empresa de gestión de activos Mercer, encontró que la proporción de los que afirman que su departamento utiliza análisis predictivo aumentó del 10 % en 2016 al 39 % en 2020.

Foto: El producto principal de Pymetrics, un conjunto de 12 juegos basados en inteligencia artificial que, según la empresa, pueden distinguir los atributos sociales, cognitivos y emocionales de un solicitante de empleo. Créditos: Pymetrics

Foto: El producto principal de Pymetrics, un conjunto de 12 juegos basados en inteligencia artificial que, según la empresa, pueden distinguir los atributos sociales, cognitivos y emocionales de un solicitante de empleo. Créditos: Pymetrics

Sin embargo, los investigadores han descubierto que algunas herramientas de contratación, igual que otras aplicaciones de IA, producen resultados sesgados, favoreciendo de forma inconsciente a hombres o a personas de ciertos orígenes socioeconómicos, por ejemplo. Muchos abogan por una mayor transparencia y más regulación. La solución que se propone con mayor frecuencia son las auditorías de IA.

El año pasado, Pymetrics contrató a un equipo de informáticos de la Universidad Northeastern (EE. UU.) para que auditara su algoritmo de contratación. Fue una de las primeras veces que una empresa de este tipo solicitaba una auditoría externa para su propia herramienta. La CEO, Frida Polli, cree que su experiencia podría convertirse en un modelo para el cumplimiento de una propuesta de ley que requiere tales auditorías para las empresas en la ciudad de Nueva York (EE. UU.), donde Pymetrics tiene su sede.

Pymetrics comercializa su software como «completamente libre de sesgos».

«Lo que está haciendo Pymetrics, incorporar a una tercera parte neutra para auditar, es una muy buena dirección en la que avanzar. Si pueden impulsar a la industria para que sea más transparente, es un paso adelante realmente positivo «, opina la profesora de derecho de la Universidad de Washington en St. Louis (EE. UU.) Pauline Kim, especialista en derecho laboral e inteligencia artificial.

No obstante, a pesar de toda la atención que han recibido las auditorías de IA, su capacidad para detectar y proteger contra el sesgo sigue sin demostrarse. El término «auditoría de IA» puede significar muchas cosas, lo que dificulta confiar en sus resultados en general. Las auditorías más rigurosas pueden tener un alcance limitado. E incluso con un acceso ilimitado a las entrañas de un algoritmo, puede resultar sorprendentemente difícil afirmar con certeza si este trata a los solicitantes de una manera justa. En el mejor de los casos, las auditorías ofrecen una imagen incompleta y, en el peor, podrían ayudar a las empresas a ocultar algunas prácticas problemáticas o controvertidas detrás del sello de aprobación de un auditor.

Los detalles de una auditoría de IA

En la actualidad, ya se utilizan muchos tipos de herramientas de contratación habilitadas por la IA, como el software que analiza las expresiones faciales, el tono y el lenguaje de un candidato durante la entrevista por vídeo, así como los programas que revisan currículums, prevén la personalidad o investigan la actividad en las redes sociales de un aspirante.

Independientemente del tipo de herramienta que vendan, los proveedores de inteligencia artificial para la contratación generalmente prometen que sus tecnologías encontrarán candidatos mejor calificados y más diversos a un coste menor y en menos tiempo que los tradicionales departamentos de recursos humanos. Sin embargo, hay muy pocas pruebas que lo demuestren y, de todas formas, la auditoría de IA del algoritmo de Pymetrics tampoco se centró en demostrar su eficacia. En cambio, tenía como objetivo determinar si esa herramienta de contratación en particular discrimina gravemente a los candidatos por motivos de raza o género.

El investigador de la Universidad de Northeastern Christo Wilson había examinado distintos algoritmos antes, incluidos los que impulsan el aumento de precios de Uber y el motor de búsqueda de Google. Pero, hasta que Pymetrics lo llamó, nunca había trabajado directamente con la empresa que investigaba.

El equipo de Wilson (su colega Alan Mislove y dos estudiantes graduados) se basó en los datos de Pymetrics y tuvo acceso a los científicos de datos de la empresa. Los auditores eran editorialmente independientes, pero acordaron informar a Pymetrics sobre cualquier hallazgo negativo antes de la publicación. La compañía pagó a Northeastern 87.667 euros a través de una subvención que incluía 54.391 euros para los salarios de Wilson y su equipo.

El producto principal de Pymetrics es un conjunto de 12 juegos que, según la empresa, se basan principalmente en experimentos de ciencia cognitiva. Los juegos no están pensados para ganar o perder; están diseñados para identificar atributos cognitivos, sociales y emocionales de un candidato, incluida la tolerancia al riesgo y la capacidad de aprendizaje. Pymetrics comercializa su software como «completamente libre de sesgos«. Wilson y Pymetrics acordaron que los auditores se centrarían en una pregunta específica: ¿Son justos los modelos de la empresa?

Los investigadores basaron la definición de equidad en lo que coloquialmente se conoce como la regla de los cuatro quintos, que se ha convertido en un estándar de la contratación en Estados Unidos. La Comisión para la Igualdad de Oportunidades en el Empleo (EEOC, por su sigla en inglés) publicó sus consejos en 1978 que establecen que los procedimientos de contratación deben seleccionar aproximadamente la misma proporción de hombres y mujeres, y de personas de diferentes grupos raciales. Según la regla de los cuatro quintos, explica Kim, «si los hombres pasaran al siguiente paso en el proceso de contratación el 100 % de las veces, las mujeres deben superarlas, como mínimo, el 80 % de las ocasiones».

Si las herramientas de contratación de una empresa no respetan la regla de los cuatro quintos, la EEOC podría examinar sus prácticas más de cerca. Kim detalla: «Para un empleador, esa revisión no es mala. Si se aseguran de que sus herramientas no son desproporcionadamente discriminatorias, probablemente no llamarán la atención de los reguladores federales».

Para averiguar si el software de Pymetrics cumple con esta regla, el equipo de Northeastern primero tuvo que comprender cómo funcionaba la herramienta.

Cuando un nuevo cliente solicita los servicios de Pymetrics, debe seleccionar a al menos 50 empleados que hayan tenido éxito en el puesto de trabajo que la empresa quiere cubrir. Estos empleados juegan los videojuegos de Pymetrics para generar datos de entrenamiento. Después, el sistema de Pymetrics compara los datos de esos 50 empleados con los datos del juego de más de 10.000 personas seleccionadas al azar entre más de dos millones. Luego, el sistema construye un modelo que identifica y clasifica las habilidades específicas de los empleados exitosos del cliente.

Para verificar si hay sesgos, Pymetrics compara este modelo con otro conjunto de datos de aproximadamente 12.000 personas (seleccionadas al azar entre más de 500.000) que no solo han jugado sus videojuegos, sino que también han revelado sus datos demográficos mediante un cuestionario. La idea consiste en determinar si el modelo pasaría la prueba de los cuatro quintos si evaluara a estas 12.000 personas.

Si el sistema detecta algún sesgo, construye y prueba más modelos hasta encontrar alguno que prediga el éxito y produzca aproximadamente las mismas tasas de aprobación para hombres y mujeres y para los miembros de todos los grupos raciales. Entonces, en teoría, incluso si la mayoría de los empleados exitosos de un cliente son hombres blancos, Pymetrics puede corregir el sesgo comparando los datos del juego de esos hombres con los datos de mujeres y personas de otros grupos raciales. Lo que busca son puntos de datos que predigan los rasgos y que no se correlacionen con la raza ni el género, pero que sí distingan a los empleados exitosos.

Wilson y su equipo de auditores querían averiguar si el mecanismo antisesgo de Pymetrics efectivamente lo previene y si se puede engañar. Para llevarlo a cabo, intentaron jugar con el sistema, por ejemplo, duplicando los datos del juego del mismo hombre blanco muchas veces con la intención de usarlos para construir un modelo. Wilson cuenta que el resultado siempre era el mismo: «Por la forma en la que se diseñó su código y la manera en la que los científicos de datos usan la herramienta, no había un modo obvio de engañarlo para que produjera algo sesgado y lo aceptara como correcto».

El otoño pasado, los auditores compartieron sus hallazgos con la empresa: el sistema de Pymetrics cumple la regla de los cuatro quintos. El equipo de Northeastern recientemente publicó online este estudio del algoritmo y presentará un informe sobre su trabajo en marzo en la conferencia de responsabilidad algorítmica FAccT. «La gran conclusión es que Pymetrics realiza un muy buen trabajo«, afirma Wilson.

Una solución imperfecta

Pero, aunque el software de Pymetrics cumple con la regla de los cuatro quintos, la auditoría no ha demostrado que la herramienta esté totalmente libre de sesgos ni de que sea capaz de elegir a los candidatos mejor cualificados para un puesto de trabajo.

El estudiante de doctorado en ciencias de la computación en la Universidad de Cornell (EE. UU.) Manish Raghavan, quien ha publicado muchos artículos sobre inteligencia artificial y la contratación, afirma: «De hecho, parecía que la pregunta más bien debería ser: ‘¿Pymetrics está haciendo lo que dicen que hacen?’ en vez de ‘¿Están haciendo lo correcto o lo apropiado?'».

«De hecho, parecía que la pregunta más bien debería ser: ‘¿Pymetrics está haciendo lo que dicen que hacen?’ en vez de ‘¿Están haciendo lo correcto o lo apropiado?'»

Por ejemplo, la regla de los cuatro quintos solo requiere que personas de diferentes géneros y grupos raciales pasen a la siguiente ronda del proceso de contratación con aproximadamente las mismas tasas. Una herramienta de contratación de inteligencia artificial podría satisfacer ese requisito y aún resultar tremendamente inconsistente a la hora de predecir el desempeño de las personas de diferentes grupos después de ser contratadas. Y si una herramienta predice el éxito con más precisión para los hombres que para las mujeres, por ejemplo, eso significaría que en realidad no está identificando a las mujeres mejor cualificadas, por lo que las mujeres contratadas «podrían no tener tanto éxito en el trabajo», sostiene Kim.

Otro tema que ni la regla de los cuatro quintos ni la auditoría de Pymetrics abordan es la interseccionalidad. La regla compara a los hombres con las mujeres y un grupo racial con otro para ver si pasan al mismo ritmo, pero no compara, por ejemplo, a los hombres blancos con los hombres asiáticos o mujeres negras. «Podría haber algo que satisfaga la regla de los cuatro quintos [para] los hombres contra las mujeres y los negros contra los blancos, pero podría ocultar el sesgo contra las mujeres negras», según Kim.

Pymetrics no es la única empresa que ha auditado su IA. HireVue, otro gran proveedor de software de contratación vía IA, pidió a la empresa O’Neil Risk Consulting and Algorithmic Auditing (ORCAA) que evaluara uno de sus algoritmos. Esa compañía es propiedad de la científica de datos Cathy O’Neil, que también es autora de Weapons of Math Destruction, uno de los libros más populares y fundamentales sobre el sesgo de la IA, que lleva años abogando por las auditorías de IA.

ORCAA y HireVue centraron su auditoría en un producto: las evaluaciones de contratación de HireVue, que muchas empresas utilizan para evaluar a universitarios recién graduados. En este caso, ORCAA no evaluó el diseño técnico de la herramienta en sí. En cambio, la empresa entrevistó a las partes interesadas (el solicitante de empleo, el especialista en ética en inteligencia artificial y varias organizaciones sin ánimo de lucro) sobre los posibles problemas con las herramientas y dio recomendaciones a HireVue para mejorarlas. El informe final se publicó en el sitio web de HireVue, pero solo se puede leer tras firmar un compromiso de no divulgación

El miembro de Brookings Institution que ha estudiado las herramientas de contratación de IA y que está familiarizado con ambas auditorías Alex Engler, afirma que la de Pymetrics es mejor: «Hay una gran diferencia en la profundidad del análisis que se realizó». Pero ninguna de las auditorías abordó si los productos realmente ayudan a las empresas a tomar mejores decisiones de contratación. Y ambas fueron financiadas por las empresas auditadas, lo que crea «un pequeño riesgo de que el auditor se vea influenciado por el hecho de que se trata de un cliente«, señala Kim.

Los críticos afirman que, por estas razones, las auditorías voluntarias no bastan. Los científicos de datos y expertos en responsabilidad ya están presionando por una regulación más amplia de las herramientas de contratación de IA, así como estándares para auditarlas.

Llenar los huecos

Algunas de estas medidas ya han empezado a surgir. En 2019, los senadores estadounidenses Cory Booker y Ron Wyden y la congresista Yvette Clarke presentaron la Ley de Responsabilidad Algorítmica para que las auditorías de sesgo sean obligatorias en las grandes empresas que utilizan inteligencia artificial, aunque su proyecto de ley no ha sido ratificado.

También hay alguna iniciativa a nivel estatal. La Ley de Entrevistas por Vídeo con IA en Illinois (EE. UU.), que entró en vigor en enero de 2020, requiere que las empresas informen a los candidatos si usan IA en entrevistas por vídeo. Algunas ciudades también están tomando medidas: en Los Ángeles (EE. UU.), en pasado noviembre, el concejal municipal Joe Buscaino propuso una resolución de contratación justa para los sistemas automatizados.

La ley de la ciudad de Nueva York en especial podría servir de modelo para otras ciudades y países. La norma obligaría a los proveedores de herramientas de contratación automatizadas a someterse a auditorías anuales. También requeriría que las empresas que utilizan las herramientas informen a los candidatos de qué características usó su sistema para tomar una decisión.

Pero la cuestión de cómo deberían ser esas auditorías anuales permanece abierta. Para muchos expertos, una auditoría similar a la de Pymetrics no llegaría muy lejos para determinar si estos sistemas discriminan, ya que esa auditoría no verificó la interseccionalidad ni evaluó la capacidad de la herramienta para medir con precisión los rasgos que afirma medir para las personas de diferentes razas y géneros.

Y a muchos críticos les gustaría que las auditorías fueran realizadas por autoridades públicas en vez de por empresas privadas para evitar conflictos de intereses. «Antes de usar cualquiera de estos sistemas, debería haber una regulación preventiva revisada por la Comisión para la Igualdad de Oportunidades en el Empleo, quien podría otorgarle una licencia», propone el profesor de la Facultad de Derecho de Brooklyn (EE. UU.) y experto en responsabilidad algorítmica Frank Pasquale. Su idea consiste en un proceso de aprobación previa para las herramientas de contratación algorítmica similar al que usa la Administración de Alimentos y Medicamentos con los medicamentos.

Hasta ahora, la EEOC ni siquiera ha emitido pautas claras sobre los algoritmos de contratación que ya se usan. Pero las cosas podrían empezar a cambiar pronto. En diciembre, 10 senadores enviaron una carta a la EEOC preguntando si tenía la autoridad para comenzar a vigilar los sistemas de contratación por IA para prevenir la discriminación contra las personas de color, que ya se habían visto afectadas de manera desproporcionada por la pérdida de empleos durante la pandemia.