La red social dispone de un enorme almacén de nuevos ordenadores específicamente diseñados para acelerar sus investigaciones de aprendizaje de máquinas e inteligencia artificial

Si accede a Facebook desde la mitad occidental de Norteamérica hay muchas probabilidades de que sus datos sean captados por un ordenador enfriado con el aire con aroma a enebro y salvia del desierto alto del centro de Oregón (EEUU).

En la cuidad de aproximadamente 9.000 habitantes de Prineville, Facebook almacena los datos de cientos de millones de personas más. Cuatro edificios gigantes alojan filas y filas de ordenadores en unos 75.000 metros cuadrados, alineadas con precisión para permitir la entrada de los secos y generalmente frescos vientos de verano que soplan desde el noroeste. Las filas de servidores apilados con parpadeantes luces azules y verdes ronronean al procesar los inicios de sesión y los nuevos registros de "me gusta" y LOL.

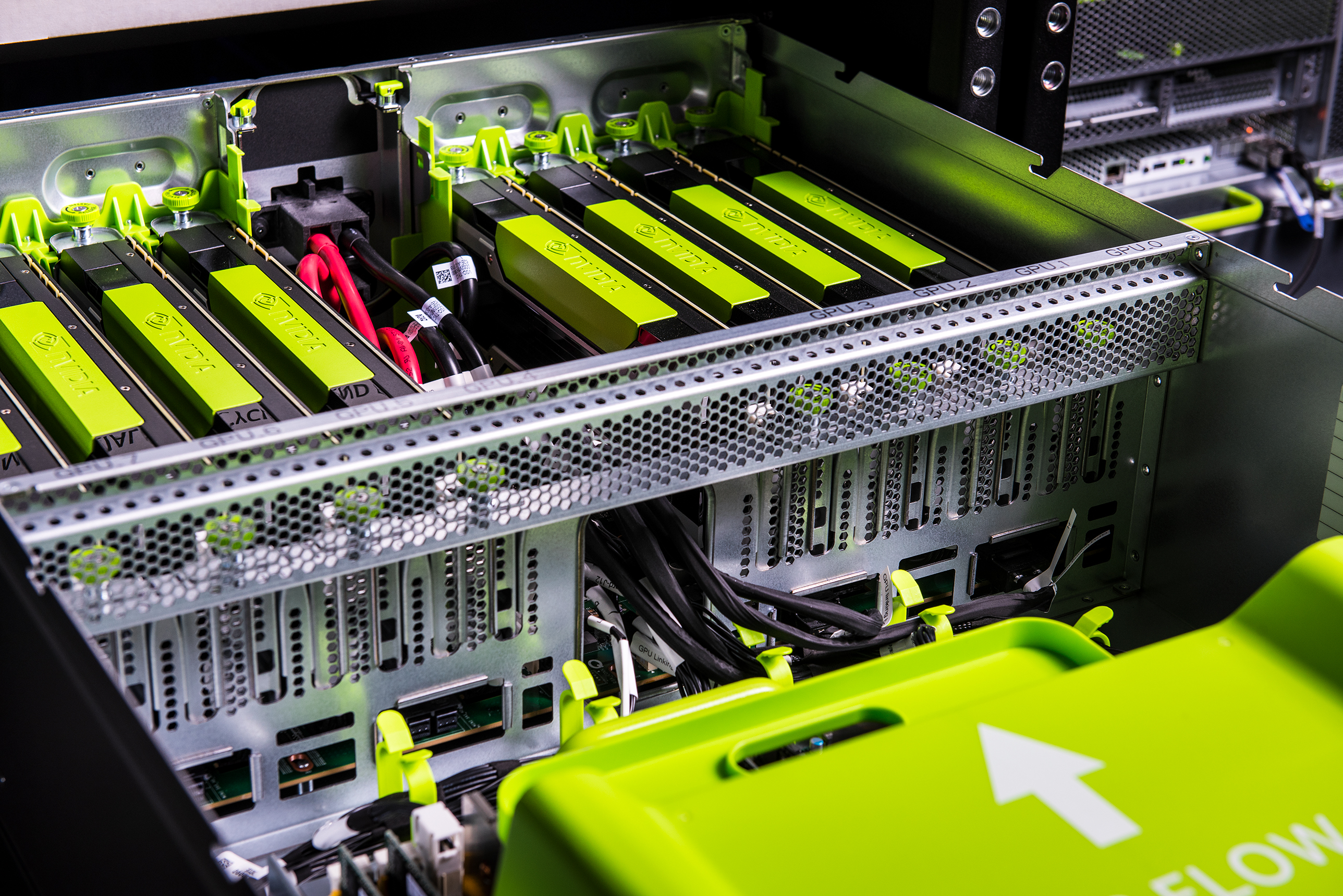

Foto: Facebook ha instalado nuevos servidores de alta potencia para ayudar a sus investigadores de inteligencia artificial a avanzar más rápido. Están alimentados por chips GPU (las tarjetas verdes al fondo de la imagen) hechos por Nvidia. Crédito: Facebook.

Foto: Facebook ha instalado nuevos servidores de alta potencia para ayudar a sus investigadores de inteligencia artificial a avanzar más rápido. Están alimentados por chips GPU (las tarjetas verdes al fondo de la imagen) hechos por Nvidia. Crédito: Facebook.

Últimamente Facebook ha añadido algunas nuevas máquinas a la comunidad de Prineville. La empresa ha instalado nuevos servidores de alta potencia para acelerar los esfuerzos por entrenar el software para hacer cosas como traducir actualizaciones a otros idiomas, aumentar la inteligencia de su asistente virtual y comprender textos.

El diseño de los nuevos servidores Big Sur de Facebook se basa en unos procesadores de alta potencia originalmente desarrollados para el procesamiento gráfico, conocidos como GPU. Estos chips son responsables de los recientes avances en la tecnología de inteligencia artificial (IA) que ha nacido de una técnica conocida como aprendizaje profundo. El software ha mejorado notablemente a la hora de entender imágenes y el habla gracias a la potencia de las GPU que permiten que se apliquen ideas antiguas sobre cómo entrenar software con conjuntos de datos mucho más grandes y complejos (ver El hombre que enseña a las máquinas a entender el lenguaje).

Uno de los ingenieros de Facebook que trabaja con los servidores llamado Kevin Lee explica que ayudan a los investigadores de Facebook a entrenar el software con una cantidad mayor de datos al trabajar más rápido. "Estos servidores representan hardware desarrollado específicamente para las investigaciones de IA y el aprendizaje de máquinas. Las GPU pueden sacar una foto y descomponerla en diminutas secciones y trabajar en todas ellas a la vez", detalla.

Facebook construye cada servidor Big Sur alrededor de ocho GPU hechas por Nvidia, el proveedor líder de este tipo de chip. Lee rehusó confirmar exactamente cuántos servidores han sido desplegados pero dijo que la empresa dispone de "miles" de GPU en funcionamiento. Servidores Big Sur han sido instalados en los centros de datos de la empresa en Prineville y Ashburn, Virginia (EEUU).

Puesto que las GPU tienen un altísimo consumo energético, Facebook tiene que distribuirlas de forma menos densa que otros tipos de servidores del centro de datos, para evitar generar focos de calor que dificultarían la labor del sistema de enfriamiento y gastarían más energía. Un armario de servidor de más de 0,2 metros de alto alojan unos ocho servidores Big Sur que en otras circunstancias tiene capacidad suficiente para alojar 30 servidores convencionales de Facebook, de los que se ocupan de hacer el trabajo más rutinario de servir los datos de usuario.

Facebook para nada se encuentra sola en la operación de gigantes centros de datos o la colección de GPU para alimentar las investigaciones de aprendizaje de máquinas. Microsoft, Google y la empresa china de búsquedas de internet Baidu se han apoyado en los GPU para alimentar sus investigaciones de aprendizaje profundo.

Foto: Los nuevos servidores para las investigaciones de inteligencia artificial dentro del centro de datos de la empresa en Prineville, Oregon. Crédito: Facebook.

Foto: Los nuevos servidores para las investigaciones de inteligencia artificial dentro del centro de datos de la empresa en Prineville, Oregon. Crédito: Facebook.

La red social es singular en el hecho de haber abierto los diseños de Big Sur y de sus otros diseños de servidor, además de los planos de su centro de datos en Prineville. La empresa los dona a una organización sin ánimo de lucro llamada Open Compute Project, fundada por Facebook en 2011 para animar a las empresas de computación a colaborar en diseños para hardware de centro de datos de bajo coste y altamente eficientes. Se considera que el proyecto ha ayudado a las empresas asiáticas de hardware y apretado las tuercas a los proveedores tradicionales como Dell y HP.

Cuando Big Sur fue anunciado este año, el director de las investigaciones de IA de Facebook, Yann LeCun, afirmó que hacer disponibles los diseños podría acelerar los progresos del campo al habilitar a más organizaciones a desarrollar potentes infraestructuras de aprendizaje de máquinas (ver Facebook también empieza a regalar su tecnología de inteligencia artificial).

Pero los futuros servidores de aprendizaje de máquinas desarrollados con los planos de Facebook puede que no se construyan en torno a las GPU que forman su núcleo hoy. Múltiples empresas están trabajando en nuevos diseños de chip más específicamente adaptados para las matemáticas del aprendizaje profundo de las GPU.

Google anunció en mayo que había empezado a emplear un chip de su propio diseño, llamado TPU, para alimentar software de aprendizaje profundo como el reconocimiento de voz. El chip actual parece estar adaptado a la ejecución de algoritmos después de haber sido entrenados, no para el paso inicial de entrenamiento que los servidores Big Sur están diseñados para acelerar, pero Google está trabajando en un chip de segunda generación. Nvidia y varias start-ups incluidas Nervana Systems también están trabajando en chips personalizados para el aprendizaje profundo (ver Intel mira desde fuera mientras otras compañías prosperan en la IA).

El profesor adjunto de la Universidad de Purdue (EEUU) Eugenio Culurciello dice que la utilidad del aprendizaje profundo significa que tales chips parecen estar destinados a una adopción masiva. "Hace tiempo que existe una gran necesidad y sólo va en aumento", afirma.

Al preguntarle si Facebook está trabajando en el desarrollo de sus propios chips personalizados, Lee contestó que la empresa "lo está mirando".