La nueva inteligencia artificial de OpenIA produce textos increíblemente realistas gracias a la semántica distributiva, un modelo muy potente pero incapaz de que la máquina entienda lo que dice. Es uno de los cuatro enfoques actuales del procesamiento del lenguaje natural

El jueves pasado, la empresa de investigación sin ánimo de lucro OpenAI publicó un nuevo modelo de lenguaje capaz de generar textos increíblemente realistas. Sus escritos resultan tan convincentes que los investigadores se han negado publicar el sistema en código abierto para evitar que la gente lo use para producir noticias falsas de forma masiva.

Aunque este impresionante resultado da un extraordinario salto frente a cualquier logro de los modelos lingüísticos existentes, la técnica empleada no es precisamente nueva. El gran avance se debe principalmente al aumento de datos de entrenamiento del algoritmo, un truco que también ha sido responsable de la mayoría de los recientes avances relacionados con la forma de enseñar a la inteligencia artificial (IA) a leer y escribir. "Es sorprendente lo que se puede hacer con más [...] datos y modelos más grandes", comenta el profesor de informática en la Universidad de Stanford (EE. UU.) Percy Liang.

Los textos del sistema de OpenIA son tan buenos que podrían pasar por humanos. Pero su capacidad de redacción no debe confundirse con una comprensión genuina del lenguaje, que es el objetivo final del subcampo de IA conocido como procesamiento de lenguaje natural (PLN). (Existe un análogo en la visión artificial: un algoritmo puede generar imágenes altamente realistas sin tener una verdadera comprensión visual). De hecho, lograr que las máquinas alcancen ese nivel de comprensión es una tarea que aún se escapa a los investigadores de PLN. Liang cree que podrían tardar años, incluso décadas, en alcanzar ese objetivo, y cree que para ello hagan falta técnicas que aún no existen.

En el desarrollo actual de las técnicas de PNL predominan cuatro filosofías diferentes del lenguaje. Comenzamos con la que ha usado OpenAI.

1. Semántica distributiva

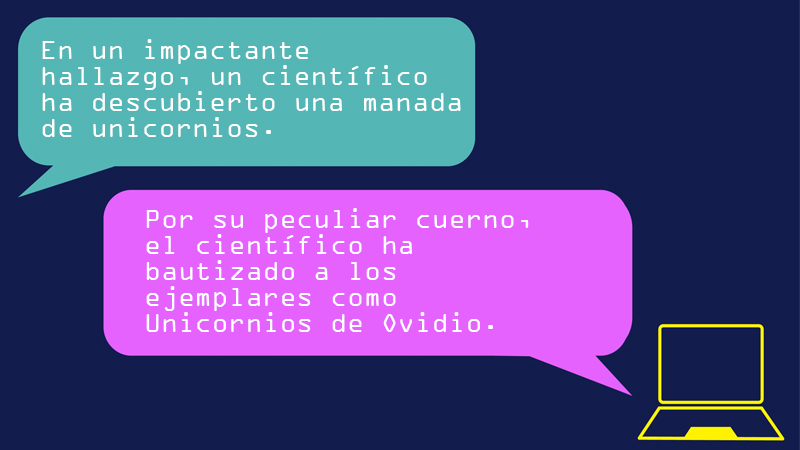

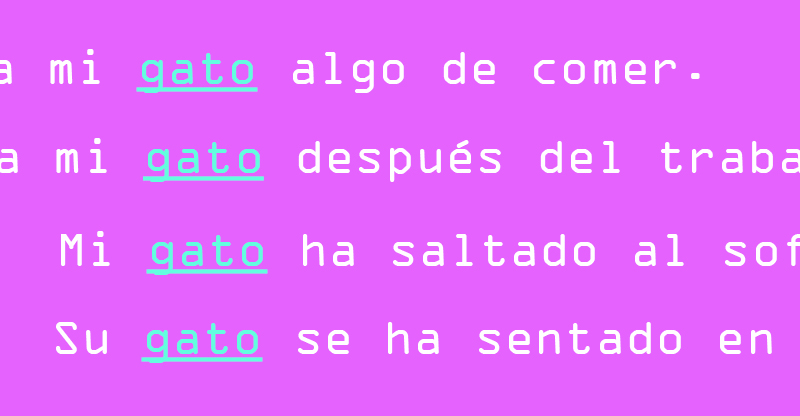

Filosofía lingüística. El significado de las palabras se extrae a partir de sus usos. Por ejemplo, el significado de las palabras "gato" y "perro" está relacionado porque ambos términos se usan más o menos de la misma manera. Se puede alimentar y acariciar un gato, y también un perro. Sin embargo, no se puede alimentar y acariciar una naranja.

Cómo se traduce a PLN. Los algoritmos basados en semántica distributiva han sido en gran parte responsables de los recientes avances en PLN. Usan el aprendizaje automático para procesar textos, y encuentran patrones al contar con qué frecuencia y cercanía se usa cada palabra. Luego, los modelos resultantes pueden usar esos patrones para construir frases o párrafos completos y autocompletar o ayudar a otros sistemas de texto predictivo. En los últimos años, algunos investigadores también han comenzado a experimentar observando las distribuciones de secuencias aleatorias de caracteres en lugar de palabras, y así los modelos pueden manejar con mayor facilidad los acrónimos, la puntuación, la jerga y otros elementos que no aparecen en el diccionario, así como los idiomas que no tienen delimitaciones claras entre palabras.

Pros. Estos algoritmos son flexibles y escalables, ya que pueden aplicarse en cualquier contexto y aprender de datos no etiquetados.

Contras. Los modelos no comprenden realmente las frases que construyen. Al fin y al cabo, más que escribir, solo generan asociaciones de palabras.

2. Semántica estructural

Filosofía lingüística. El lenguaje se usa para describir acciones y acontecimientos, por lo que las frases se pueden subdividir en sujetos, verbos y complementos: quién, qué, dónde y cuándo.

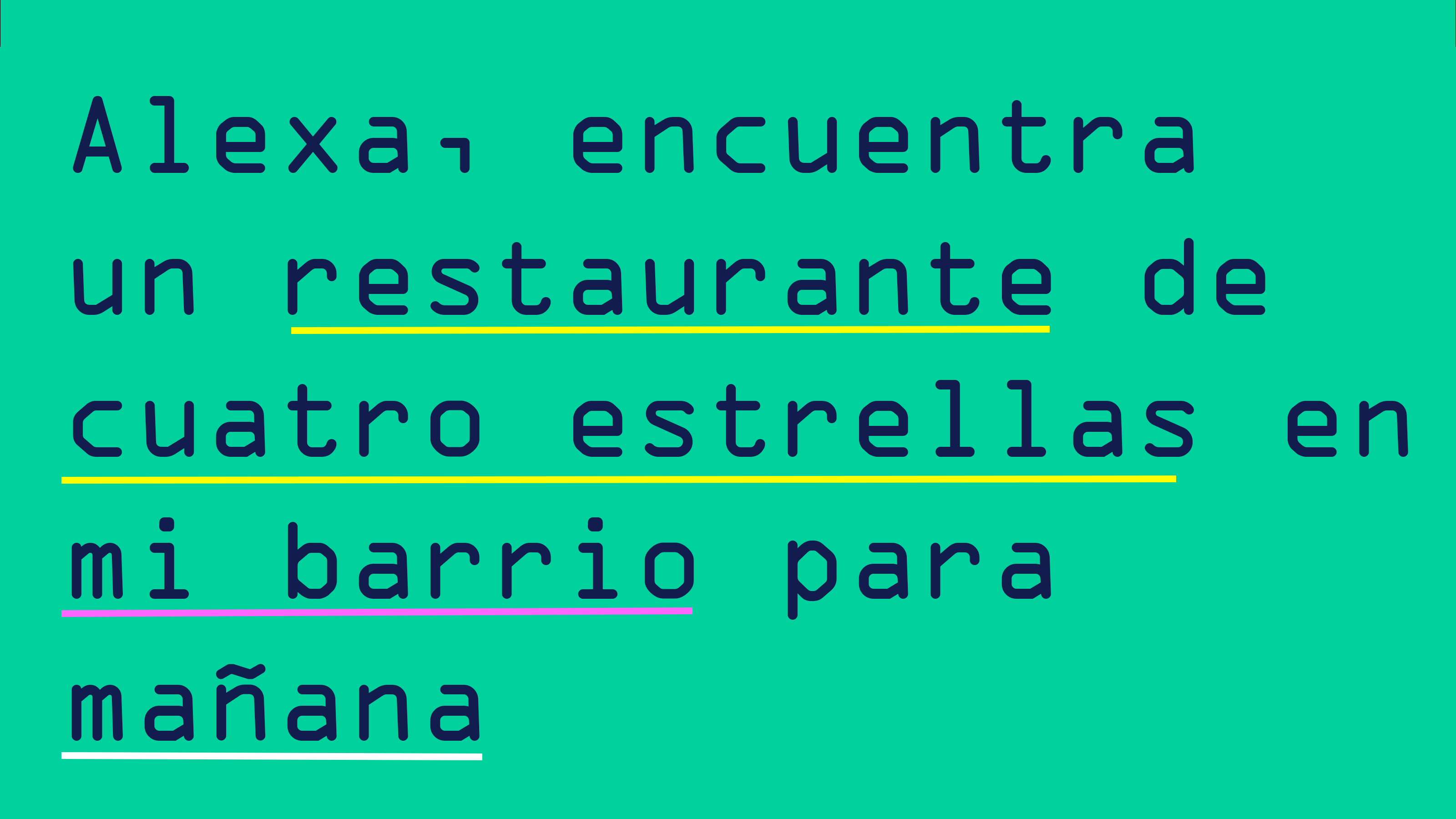

Cómo se traduce a PLN. Los algoritmos basados en la semántica estructural utilizan un conjunto de reglas o muchos datos de entrenamiento etiquetados para aprender a descomponer las frases. Son particularmente buenos para analizar comandos simples y, por lo tanto, son útiles para chatbots o asistentes de voz. Si pedimos a Alexa que "encuentre un restaurante con cuatro estrellas para mañana", por ejemplo, el algoritmo descubriría cómo ejecutar la frase dividiéndola en la acción ("encontrar"), en el qué ("restaurante con cuatro estrellas"), y en el cuándo ("mañana").

Pros. A diferencia de los algoritmos de distribución semántica, que no comprenden el texto del que aprenden, los algoritmos de semántica estructural pueden distinguir las diferentes partes de información en una frase. Se pueden usar para responder a preguntas como "¿Cuándo tendrá lugar este evento?"

Contras. Estos algoritmos solo pueden manejar frases muy simples y, por lo tanto, son incapaces de captar matices. Como requieren una gran cantidad de capacitación específica para el contexto, tampoco son demasiado flexibles.

3. Semántica teórica

Filosofía lingüística. El lenguaje se utiliza para comunicar el conocimiento humano.

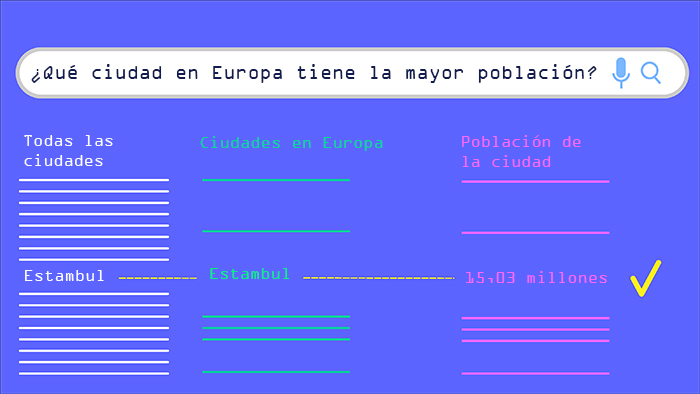

Cómo se traduce a PLN. La semántica teórica se basa en la vieja idea de la IA de que todo el conocimiento humano se puede codificar, o modelar, en una serie de reglas lógicas. Entonces, si sabemos que las aves pueden volar y las águilas son aves, entonces podemos deducir que las águilas pueden volar. Este enfoque ya no está de moda porque los investigadores se dieron cuenta de que había demasiadas excepciones para cada regla (por ejemplo, los pingüinos son aves pero no pueden volar). Pero los algoritmos basados en la semántica teórica siguen siendo útiles para extraer información de los modelos de conocimiento, como las bases de datos. Al igual que los algoritmos de semántica estructural, analizan las frases deshaciéndolas en partes. Pero mientras que la semántica estructural define esas partes como quién, qué, dónde y cuándo, la semántica teórica las define como las reglas lógicas que codifican el conocimiento. Por ejemplo, en la pregunta "¿Cuál es la ciudad más poblada de Europa?" un algoritmo del modelo teórico la dividiría en una serie de preguntas: "¿Cuáles son todas las ciudades del mundo?", "¿Cuáles de ellas están en Europa?", "¿Qué población tienen las ciudades?", "¿Qué población es la mayor?". Entonces, sería capaz de cruzar el modelo de conocimiento para obtener la respuesta final.

Pros. Estos algoritmos dan a las máquinas una capacidad real de responder a preguntas complejas y matizadas.

Contras. Es necesario un modelo de conocimiento, que tarda mucho tiempo en crearse y no se puede aplicar en diferentes contextos.

4. Semántica con ejemplos

Filosofía lingüística. El significado del lenguaje deriva de la experiencia vivida. En otras palabras, los seres humanos crearon el lenguaje para lograr sus objetivos, por lo que debe entenderse dentro del contexto de nuestro mundo orientado hacia los objetivos.

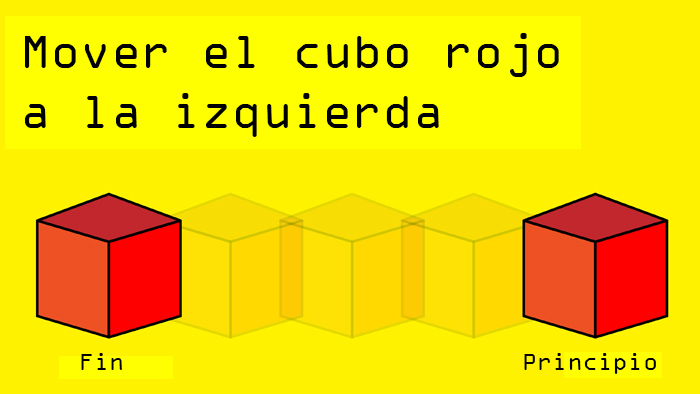

Cómo se traduce a PLN. Este es el enfoque más reciente y el que Liang considera es el más prometedor. Intenta imitar cómo los humanos aprenden el lenguaje a lo largo de su vida: la máquina comienza en blanco y va aprendiendo a asociar las palabras con sus significados correctos a través de la conversación y la interacción. En un ejemplo simple, si quisiéramos enseñar a un ordenador a mover objetos en un mundo virtual, le daríamos un comando como "Mover el bloque rojo a la izquierda" y luego le mostraríamos qué queremos decir. Con el tiempo, la máquina aprenderá a comprender y a ejecutar los comandos sin ayuda.

Pros. En teoría, estos algoritmos deben ser muy flexibles y acercarse lo máximo posible a una comprensión genuina del lenguaje.

Contras. La enseñanza requiere mucho tiempo, y no todas las palabras y frases son tan fáciles de ilustrar como "Mueve el bloque rojo".

A corto plazo, Liang cree que el campo del PLN verá un progreso mucho mayor en la explotación de las técnicas existentes, en particular en las que se basan en la semántica distributiva. Pero a plazo más largo, considera que todas tienen limitaciones. "Probablemente existe una brecha cualitativa entre la forma en la que los humanos entienden el lenguaje y perciben el mundo y los modelos actuales", concluye. Cerrar esa brecha probablemente requeriría una nueva forma de pensar y también mucho más tiempo.