Los creadores de una tecnología para leer las emociones faciales quieren ver si es capaz de enfrentarse a problemas más complejos que la publicidad en campos como la educación

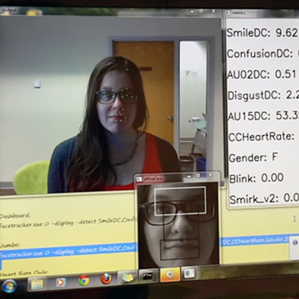

Foto: Gracias a imágenes capturadas por sencillas cámaras web, el software de Affectiva sigue el movimiento de los músculos de los labios, cejas y otras partes de la cara para averiguar el estado emocional de una persona.

Foto: Gracias a imágenes capturadas por sencillas cámaras web, el software de Affectiva sigue el movimiento de los músculos de los labios, cejas y otras partes de la cara para averiguar el estado emocional de una persona.

El año pasado, más de mil personas de cuatro países distintos se sentaron a ver 115 anuncios de televisión, como en el que unos caramelos M&M antropomórficos bailan en un bar. Mientras los veían, una serie de cámaras web registraba y enviaba las de sus expresiones a un servidor en Waltham (Massachusetts, EEUU).

Allí, un algoritmo desarrollado por una start-up llamada Affectiva llevaba a cabo lo que se conoce como codificación facial: seguía los movimientos de las cejas de los sujetos, sus caras de perplejidad, de suficiencia, de sorpresa, sus ceños fruncidos y sus sonrisas. (Se puede ver un vídeo de la tecnología en funcionamiento aquí). Cuando estos datos faciales se combinaron, posteriorment,e con los datos de ventas en el mundo real, resultó que las medidas faciales se podían usar para predecir con una fiabilidad de 75%, si las ventas de los productos anunciados aumentarían, disminuirían o se mantendrían igual después de la emisión de los anuncios. En comparación, las encuestas hechas a sujetos sobre sus sentimientos sobre los anuncios podría predecir las tendencias de venta de los productos con una fiabilidad del 70%.

Estadísticamente esto supone una mejora y, además, es un hito en el campo de la computación afectiva. Es de sobra conocido que a la gente le cuesta articular lo que siente. Ahora, está claro que las máquinas no sólo son capaces de leer algunos de sus sentimientos, sino de ir un paso más allá y predecir la probabilidad estadística del comportamiento posterior.

Dado que, sólo en Estados Unidos, el mercado de la publicidad televisiva supera los 70.000 millones de dólares anuales (unos 50.000 millones de euros), el conocimiento adquirido gracias a la codificación facial es "muy importante para la gente del negocio", afirma la directora del grupo de computación afectiva en el Media Lab del Instituto Tecnológico de Massachusetts (EEUU), Rosalind Picard y cofundadora de la empresa. Aunque Picard dejó la empresa este año, continúa como inversora.

Sin embargo, la codificación facial aún no ha cumplido con las expectativas más amplias y altruistas de sus creadores. Ayudar a vender más chocolate es genial, pero ¿cuándo ayudará la codificación facial a la gente con autismo a entender claves sociales?, ¿cuándo potenciará la capacidad de los profesores de ver qué estudiantes tiene problemas?, o ¿cuándo hará que los ordenadores sean empáticos?

Las respuestas pueden empezar a llegar a partir del mes que viene, cuando Affectiva lance un kit de desarrollo de software que permitirá a las aplicaciones aprobadas usar su plataforma. La otra cofundadora de la empresa y su directora científica, Rana el Kaliouby afirma que esperan poder difundir la tecnología más allá del marketing. Aunque no quiso nombrar a sus socios actuales o potenciales, explicó que "las empresas pueden usar nuestra tecnología para cualquier cosa desde los entornos de juego y el entretenimiento, hasta la educación y aprendizaje".

En la concepción de la empresa, las aplicaciones como la ayuda a la educación -para informar a los profesores de cuándo se sienten confusos sus alumnos, o para ayudar a niños autistas a leer emociones en las caras de otros- tenían un peso muy importante. El origen de Affectiva, que se lanzó hace cuatro años y en la actualidad cuenta con 35 empleados y 20 millones de dólares en inversión de capital riesgo (unos 15 millones de euros), está en el manifiesto del laboratorio de Picard que declaraba que los ordenadores harían un servicio a la sociedad si pudieran reconocer y reaccionar ante las emociones humanas.

A lo largo de los años, el laboratorio ha creado maquetas de prototipos de tecnologías. Entre ellas se incluyen un ratón sensible a la presión capaz de sentir cuándo tu mano lo sujeta con ansiedad; un robot llamado Kismet capaz de sonreír y levantar las cejas; el "Galvactivator", un sensor de la conductividad de la piel que mide el pulso y el sudor; y el sistema de codificación facial, desarrollado y refinado por El Kaliouby.

En un principio, Affectiva apostó por dos productos: un dispositivo que se llevaba en la muñeca llamado Q sensor, capaz de medir la conductividad de la piel, la temperatura y los niveles de actividad (medidas que pueden ser indicadoras de estrés, ansiedad, problemas para dormir, ataques y otros problemas médicos); y Affdex, el software de codificación facial. Pero, aunque en un principio el sensor Q parecía prometedor (ver "Un sensor para la muñeca te indica tu nivel de estrés" y "Un sensor detecta las emociones a través de la piel"), en abril de este año la empresa dejó de fabricar el producto, en vista de que había poco mercado potencial más allá de los investigadores que trabajan en aplicaciones como medir los signos fisiológicos que sirven para predecir ataques. Eso deja a la empresa con Affdex, que está siendo empleado, principalmente, por las empresas de investigación de mercado, entre ellas Insight Express y Millward Brown, y las empresas de productos de consumo, como Unilever y Mars.

Ahora, cuando la empresa se encuentra preparando su kit para desarrolladores, el trabajo que ya se ha hecho en investigación de mercados puede producir dividendos indirectos. Después de pasarse tres años reuniendo sujetos en todo el mundo para analizar sus reacciones vía webcam, Affectiva tiene una base de datos de más de mil millones de reacciones faciales. La precisión del sistema podría abrir el camino a aplicaciones que lean las emociones en las caras de la gente con ordenadores domésticos corrientes y dispositivos portátiles. "Affectiva está yendo a por un problema tremendamente difícil que gran parte de la comunidad académica ha estado evitando, el análisis de las expresiones faciales en entornos difíciles y sin constreñir", afirma el estudiante de doctorado de la Universidad de Cambridge (Reino Unido) Tadas Baltrusaitis, que ha escrito varios artículos sobre codificación facial.

Es más, al usar sujetos de 52 países distintos, Affectiva ha aprendido lecciones específicas relativas al género y la cultura del sujeto y el tema que se trata. La codificación facial tiene un valor especialmente importante en los casos en que gente no está dispuesta a informar sobre sus sentimientos,. Por ejemplo, según Kaliouby, cuando las mujeres indias vieron el anuncio de una crema para la piel, todas sonrieron en el punto en el que el marido del anuncio toca la tripa de su mujer. Pero ninguna de las mujeres reconoció o mencionó esa escena y mucho menos admitió haberla disfrutado.

El campo de la educación puede estar maduro para recibir la tecnología. Hay toda una serie de estudios que han demostrado su potencial. Uno de ellos, realizado por investigadores de la Universidad de California en San Diego (EEUU) -que han fundado una start-up competidora llamada Emotient- demostró que las expresiones faciales sirven para predecir la dificultad percibida de una clase en vídeo y la velocidad preferida del alumno para la reproducción. Otro, demostró que la codificación facial puede medir la implicación de los estudiantes durante una tutoría a través de iPad, y que este grado de implicación, a su vez, predice cómo de bien lo harían en los exámenes posteriormente.

Estas tecnologías pueden ser especialmente útiles para los estudiantes con dificultades de aprendizaje, explica el profesor ayudante de la Universidad Arizona State (EEUU), Winslow Borleson, autor de un artículo que describe los usos potenciales de la codificación facial y otras tecnologías. La tecnología también podría ayudar a los médicos a distinguir si un paciente entiende las instrucciones que se le dan. También podría mejorar los juegos de ordenador, detectando las emociones de los jugadores y usando ese feedback para cambiar el juego o potenciar un personaje virtual.

En su conjunto, Picard considera que la información conseguida gracias a numerosos estudios de este tipo, sugiere que existe un papel para Affdex en las aulas. La investigadora explica: "En un aula real te haces una idea de si los alumnos están atentos de manera activa, pero cuando pasas a la enseñanza en línea, ni siquiera sabes si están ahí. Ahora puedes medir no sólo si están presentes y atentos, sino que, si haces un chiste, también puedes saber si sonríen sinceramente o si creen que es una tontería".

A pesar de todo, Baltrusaitis cree que aún quedan en el aire muchas preguntas sobre qué estados emocionales son relevantes en el caso de los alumnos, y qué se debería hacer cuando se detectan dichos estados. Sotiene: "Creo que el campo tendrá que desarrollarse un poco más antes de que lo veamos aplicado a las aulas o a los cursos en línea".

El año que viene deberíamos saber mucho más sobre si la codificación facial puede tener beneficios más allá de los anuncios televisivos. Affdex se enfrenta a la competencia de otras aplicaciones y start-up, e incluso a gente del mundo de la publicidad que sigue siendo escéptica respecto a que la codificación facial sea mejor que los métodos tradicionales para medir el efecto de los anuncios. No todas las reacciones se expresan con la cara, y muchas otras herramientas de medida afirman poder leer las emociones de la gente, explica Ilya Vedrashko, director de un grupo de investigación de inteligencia de consumo en Hill Holliday, una agencia de publicidad de Boston.

Pero con cada nueva cara registrada, la tecnología se refuerza. Por eso Kaliouby cree que está preparada para abordar problemas mayores y afirma:"Queremos que la tecnología de codificación facial esté en todas partes".