Cada vez veremos más bots de conversación en diferentes plataformas y servicios, pero todavía están lejos de comprender realmente el lenguaje humano y asumir encargos difíciles

Llevo los últimos minutos chateando con George Washington, y sinceramente, parece estar bastante borracho. También parece haber estado juntándose con veinteañeros, porque dice todo el rato cosas como "mola, jejeje" y "¿te kieres unir a mi ejército, o k?".

Por supuesto, no se trata realmente del primer presidente de Estados Unidos. Es un programa de inteligencia artificial (IA) de conversación, conocido como bot de conversación o chatbot. El bot, creado por la comedia televisiva Drunk History, se ha puesto a disposición del público en la plataforma de mensajería Kik. Y aunque resulta sorprendentemente divertido, no es muy coherente.

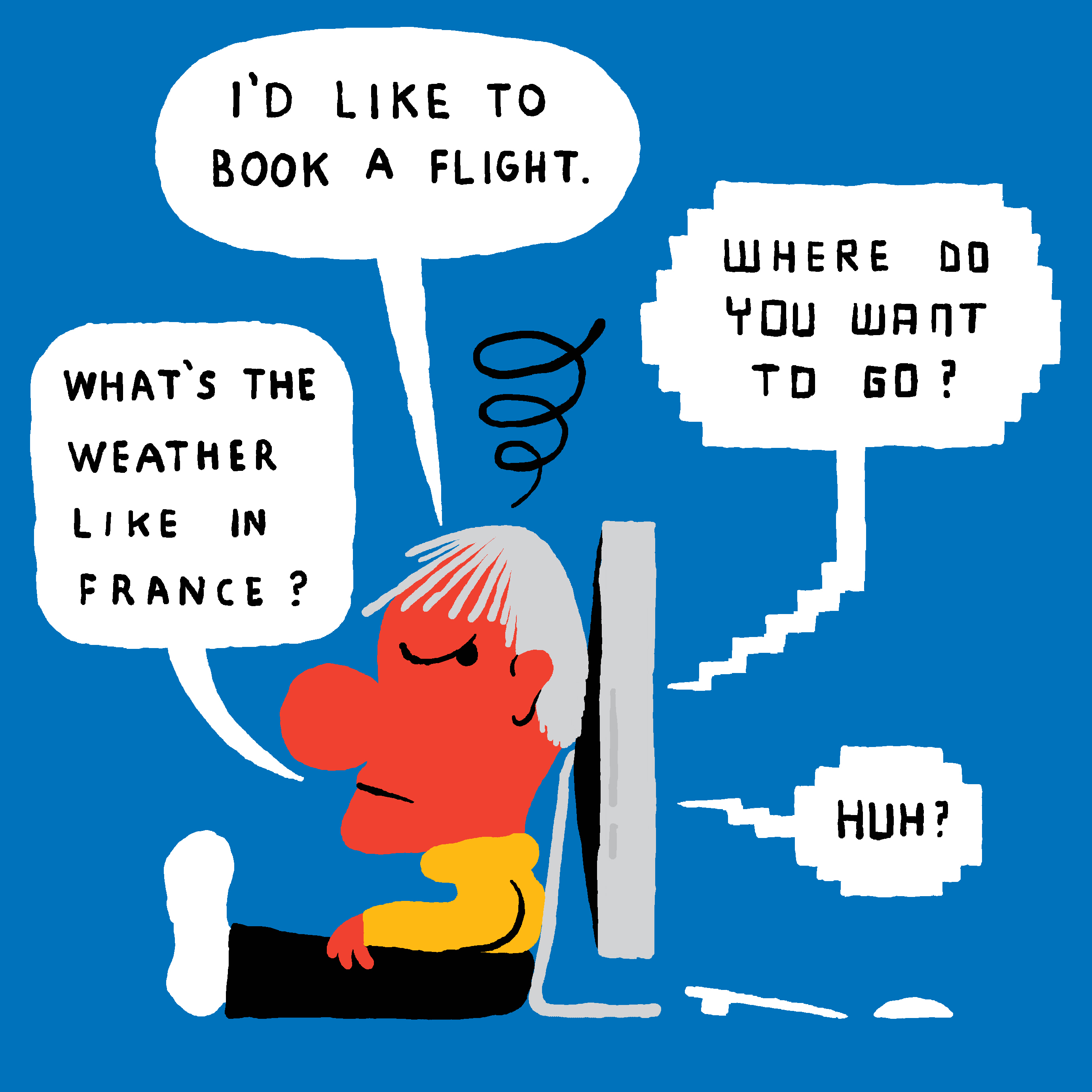

Ahora se puede conversar con todo tipo de bots mediante varios servicios de mensajería como Kik, WeChat, Telegram, y también ahora Facebook Messenger. Algunos sólo pretenden entretener, pero un número cada vez mayor de ellos está diseñado para hacer algo útil. Ya se puede reservar un vuelo, repasar los últimos titulares tecnológicos o hasta comprar una hamburguesa de Burger King con mensajes en un asistente virtual. Las start-ups se apresuran a ofrecer herramientas para acelerar el desarrollo, la gestión y la "monetización" de estos mayordomos virtuales.

Crédito: Espen Friberg.

El problema es que a los ordenadores les sigue costando entender el lenguaje humano por toda su complejidad e implícitos. Se están logrando algunos progresos impresionantes, pero los bots de conversación todavía son propensos a la confusión y los malentendidos. Y mientras que el borracho George Washington puede convertir esto en virtud, resulta menos encantador cuando uno intenta reservar un vuelo.

Los mejores bots comerciales de conversación probablemente serán los que reconozcan sus propias limitaciones. "Un escollo consiste en intentar hacer demasiadas cosas a la vez", explica el director de los servicios de plataforma en Kik, Paul Gray, cuya compañía está integrando los bots desde 2014. "Hay que empezar por lo más pequeño y sencillo".

30 Seconds to Fly, radicada en Alemania, está desarrollando un bot de conversación que funciona mediante SMS o la plataforma de mensajería Slack. La empresa utiliza herramientas proporcionadas por API.ai, una compañía de California (EEUU) que ha desarrollado un potente conjunto de herramientas para gestionar consultas escritas en lenguaje natural, pero que aún entiende mal a la gente.

"Tenemos un lenguaje coloquial que resulta muy difícil; entonces tenemos consultas específicas que no están recogidas en nuestros casos de uso", explica la cofundadora Felicia Schneider. Esto llevó a la empresa a desarrollar su propia herramienta para redirigir los mensajes a unos asistentes humanos.

Esta carrera hacia los bots de conversación se debe en parte a la popularidad de varios servicios de mensajería nuevos. Pero los esfuerzos por aprovechar los bots también se han inspirado sin duda en los increíbles progresos de otras áreas de la IA en los últimos años, como el procesamiento de imágenes y audio.

Pero procesar el lenguaje representa un reto totalmente distinto, y uno que ha atormentado a los investigadores de IA durante décadas. Los bots de conversación datan de los primeros días de la IA. Uno de los primeros, llamado Eliza, fue desarrollado en el Instituto Tecnológico de Massachusetts (MIT, EEUU) en 1964. Interpretando el papel de una psicoanalista, Eliza empleaba un sencillo truco para embaucar a la gente: planteaba preguntas estándar y a menudo volvía a replantear las propias afirmaciones de la gente en forma de pregunta. Pero cuando nos desviamos de la fórmula, Eliza rápidamente pierde el norte.

Hoy, los bots de conversación son mejores, pero no mucho, y esto apenas resulta sorprendente. No se han producido avances rompedores en el entrenamiento de los ordenadores para procesar y responder al lenguaje (un campo conocido como procesamiento del lenguaje natural) en los últimos años.

Microsoft es un buen ejemplo: ha declarado que el futuro de la computación personal serán los bots, aunque sus propios experimentos con bots conversacionales autodidactas han señalado algunos de los retos que quedan por resolver (ver La buena estrategia de Microsoft de lanzar al mundo un bot racista e insolente y La IA racista y neonazi de Microsoft fue culpa de Microsoft).

Dicho eso, las técnicas que han dado paso a avances en otras áreas, principalmente el aprendizaje profundo, están demostrando su potencial para analizar el lenguaje, según el profesor adjunto de la Universidad de Carnegie Mellon Chris Dyer. "Las redes neuronales tienen un gran potencial aquí", afirma Dyer. "Salen cada par de meses muchos trabajos interesantes sobre preguntas-respuestas".

Parte de esos trabajos ahora alimentan los bots de conversación que están emergiendo. Un vicepresidente corporativo de Microsoft llamado Derrick Connell y que supervisa la ingeniería para el motor de búsquedas de la empresa, Bing, y su asistente personal, Cortana, asegura que las preguntas hechas en Bing se utilizan para entrenar los algoritmos de los chatbots de conversación que Microsoft está poniendo a disposición de los desarrolladores. También explica que la mayoría de estos bots necesitarán volver a entrenar periódicamente para entender nuevas frases y conceptos, pero que deberían mejorar de forma continua después. "Habrá excepciones, pero con el tiempo el sistema aprenderá y mejorará continuamente", afirma Connel.

Aún queda bastante trabajo por hacer. De hecho, el asistente virtual de Facebook, llamado M, aún opera con una plantilla de humanos. Las respuestas que proporcionan estas personas están siendo utilizadas para entrenar algoritmos de aprendizaje profundo que algún día puede que sean capaces de responder por sí mismos.

Recoger y presentar información procedentes de una base de datos de manera que resulte natural a los humanos es especialmente difícil de lograr, según Dyer. Y entender la intención de una persona sigue siendo un reto por resolver.

Dada la probabilidad de la confusión y los malentendidos, apenas tiene sentido diseñar los bots de conversación para que sean demasiado generales ni hacer que ejecuten cualquier tarea importante. "Los consejos legales y médicos, y el asesoramiento psiquiátrico probablemente resultarían muy arriesgados", concluye Dyer.