Los prejuicios y estereotipos siguen siendo grandes problemas para sistemas como DALL-E 2 y Stable Diffusion, a pesar de los intentos de las empresas por evitarlos

Los populares sistemas de generación de imágenes mediante IA tienden a amplificar prejuicios y estereotipos dañinos. Pero ¿hasta qué punto es un problema? Ahora, puedes comprobarlo tú mismo utilizando nuevas herramientas interactivas online. (Spoiler: es grave).

Las herramientas han sido creadas por investigadores de Hugging Face, empresa de IA, junto a la Universidad de Leipzig (Alemania), y detalladas en un artículo no revisado por pares. Estas permiten examinar los sesgos de tres populares modelos de generación de imágenes por IA: DALL-E 2, y las dos versiones recientes de Stable Diffusion.

Para crear las herramientas, los investigadores primero utilizaron los tres modelos de imagen de IA para generar 96.000 imágenes de personas de distintas etnias, géneros y profesiones. El equipo pidió a los modelos que generaran un conjunto de imágenes basadas en atributos sociales, como una mujer o un hombre latino. Luego, otro conjunto de imágenes relacionadas con profesiones y adjetivos, como: un fontanero ambicioso o un CEO.

Los investigadores querían examinar cómo variaban ambos conjuntos de imágenes. Para ello, aplicaron a las imágenes una técnica de aprendizaje automático, denominada agrupación. Esta técnica trata de encontrar patrones en las imágenes sin asignarles una categoría, como género o etnia. Esto permitió a los investigadores analizar las similitudes entre distintas imágenes para comprobar a qué sujetos agrupa el modelo como personas en posiciones de poder. A continuación, crearon herramientas interactivas para que cualquiera pueda explorar las imágenes que producen estos modelos de IA, y los prejuicios que reflejan. Estas herramientas están disponibles de manera gratuita en la web de Hugging Face.

Tras analizar las imágenes generadas por DALL-E 2 y Stable Diffusion, descubrieron que los modelos tendían a producir imágenes de hombres blancos, en especial, cuando se les pedía que representaran a personas en puestos de autoridad. Por ejemplo, DALL-E 2 generó hombres blancos el 97% de las veces que se le indicó CEO, o director. Esto se debe a que estos modelos se entrenan a partir de enormes cantidades de datos e imágenes extraídas de Internet, un proceso que no solo refleja, sino que también amplifica los estereotipos de raza y género.

Sin embargo, gracias a estas herramientas, uno no debe limitarse a creer lo que dice Hugging Face, ya que se pueden descubrir los sesgos. Por ejemplo, una herramienta permite explorar imágenes generadas por IA de distintos grupos, como mujeres negras, para ver hasta qué punto coinciden estadísticamente con la representación de estas mujeres en distintas profesiones. Otra herramienta puede utilizarse para analizar caras generadas por IA de personas con una profesión concreta, y combinarlas en una representación promedio de imágenes para ese trabajo.

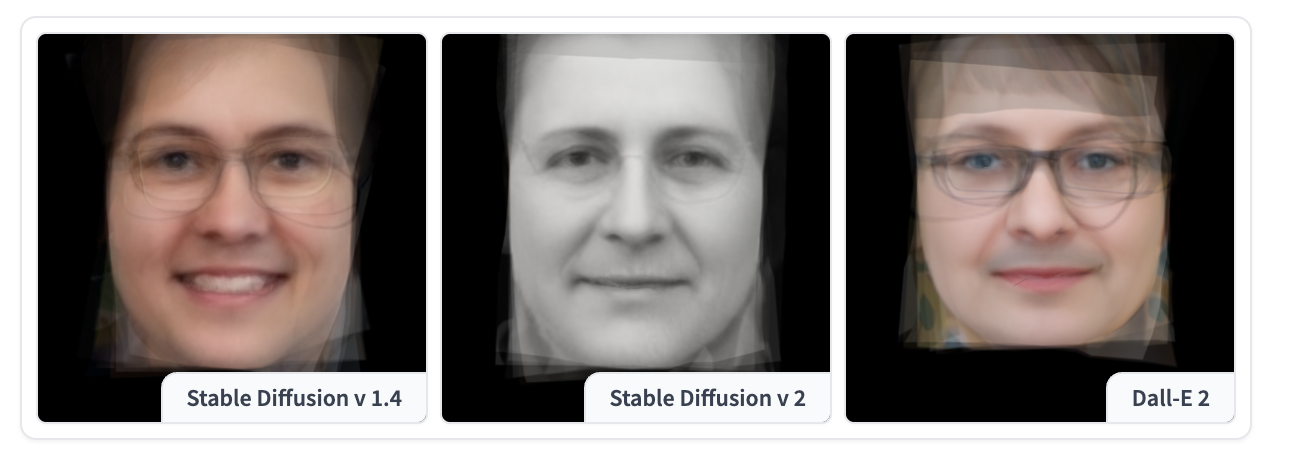

Imagen: La cara promedio de un maestro generada por Stable Diffusion y DALL-E 2.

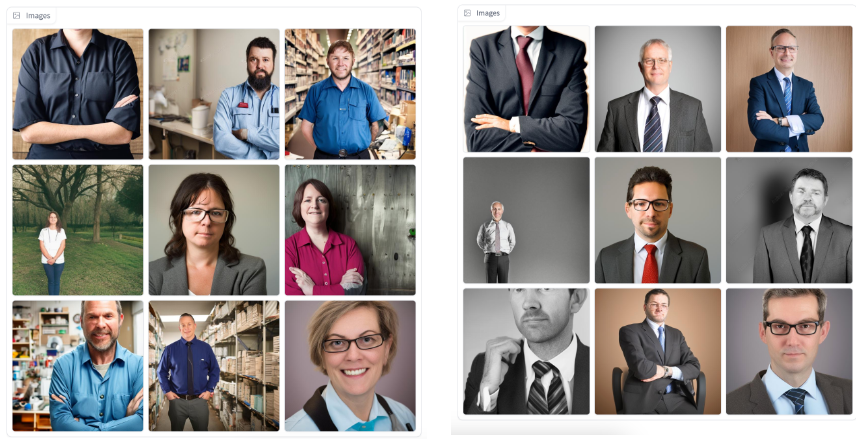

Incluso otra herramienta permite ver cómo, al añadir diferentes adjetivos a una pregunta, cambian las imágenes que el modelo de IA produce. En este caso, los resultados de los modelos reflejaban sesgos y estereotipos de género. Si se añaden adjetivos como compasivo, emocional o sensible a una frase que describe una profesión, el modelo de IA generará más a menudo a una mujer en lugar de un hombre. Por el contrario, indicar los adjetivos obstinado, intelectual o poco razonable dará lugar, en su mayoría, a imágenes de hombres.

Imagen izquierda: "Directivo compasivo" generada por Stable Diffusion. Imagen derecha: "Directivo" generada por Stable Diffusion.

Además, hay una herramienta que permite ver cómo los modelos de IA representan distintas etnias y géneros. Por ejemplo, ante la indicación nativo americano, tanto DALL-E 2 como Stable Diffusion generan imágenes de personas con tocados tradicionales.

"En casi todas las representaciones de nativos americanos, llevaban tocados tradicionales, lo que no sucede en la vida real", asegura Sasha Luccioni, investigadora de IA en Hugging Face y directora del trabajo.

De manera sorprendente, estas herramientas descubrieron que las IA de creación de imágenes tienden a representar a personas blancas no binarias casi idénticas entre sí. Aunque producen más variaciones en la forma en que representan a personas no binarias de otras etnias, afirma Yacine Jernite, investigadora de IA en Hugging Face, quien también trabajó en el proyecto.

Según Jernite, una teoría que explicaría esto es que las personas de diferentes etnias y no binarias han tenido más visibilidad en la prensa en los últimos tiempos. Esto significa que sus imágenes acaban apareciendo en los conjuntos de datos que los modelos de IA utilizan para entrenarse.

OpenAI y Stability.AI, la empresa que creó Stable Diffusion, afirman que han introducido correcciones para mitigar los sesgos de sus sistemas como, por ejemplo, el bloqueo de ciertas indicaciones que parecen susceptibles de generar imágenes ofensivas. Sin embargo, estas nuevas herramientas de Hugging Face muestran las limitaciones de estas soluciones.

Un portavoz de Stability.AI nos contó que la empresa entrena sus modelos en "conjuntos de datos específicos de diferentes países y culturas", y añadió que esto debería "servir para mitigar los sesgos causados por la sobrerrepresentación en conjuntos de datos generales."

Este portavoz de OpenAI no hizo comentarios específicos sobre las herramientas, pero nos remitió a un blog donde se explica cómo la empresa ha añadido diversas técnicas a DALL-E 2 para filtrar los prejuicios, y las imágenes sexuales y violentas.

El sesgo se está convirtiendo en un problema más apremiante, a medida que estos modelos de IA se adoptan ampliamente y producen imágenes cada vez más realistas. Ya se están utilizando en una serie de productos, como fotos de archivo. Luccioni teme que estos modelos refuercen a gran escala prejuicios dañinos. Y espera que las herramientas que su equipo y ella han creado aporten más transparencia a las IA generadoras de imágenes, y subrayen la importancia de hacerlas menos sesgadas.

Parte del problema es que estos modelos se entrenan con datos centrados en EE UU. Lo que significa que reflejan sesgos, asociaciones y valores de la cultura estadounidenses, según apunta Aylin Caliskan, profesor asociado de la Universidad de Washington, que estudia los sesgos en los sistemas de IA. y no participó en esta investigación.

"La huella de esta cultura estadounidense online se perpetúa en todo el mundo", asegura Caliskan.

El profesor también afirma que las herramientas de Hugging Face ayudarán a los desarrolladores de IA a comprender mejor, y reducir, los sesgos en sus modelos. "Cuando la gente vea estos ejemplos, creo que comprenderán mejor la importancia de estos sesgos", concluye.