Sobre IA, reconocimiento de emociones y Darwin

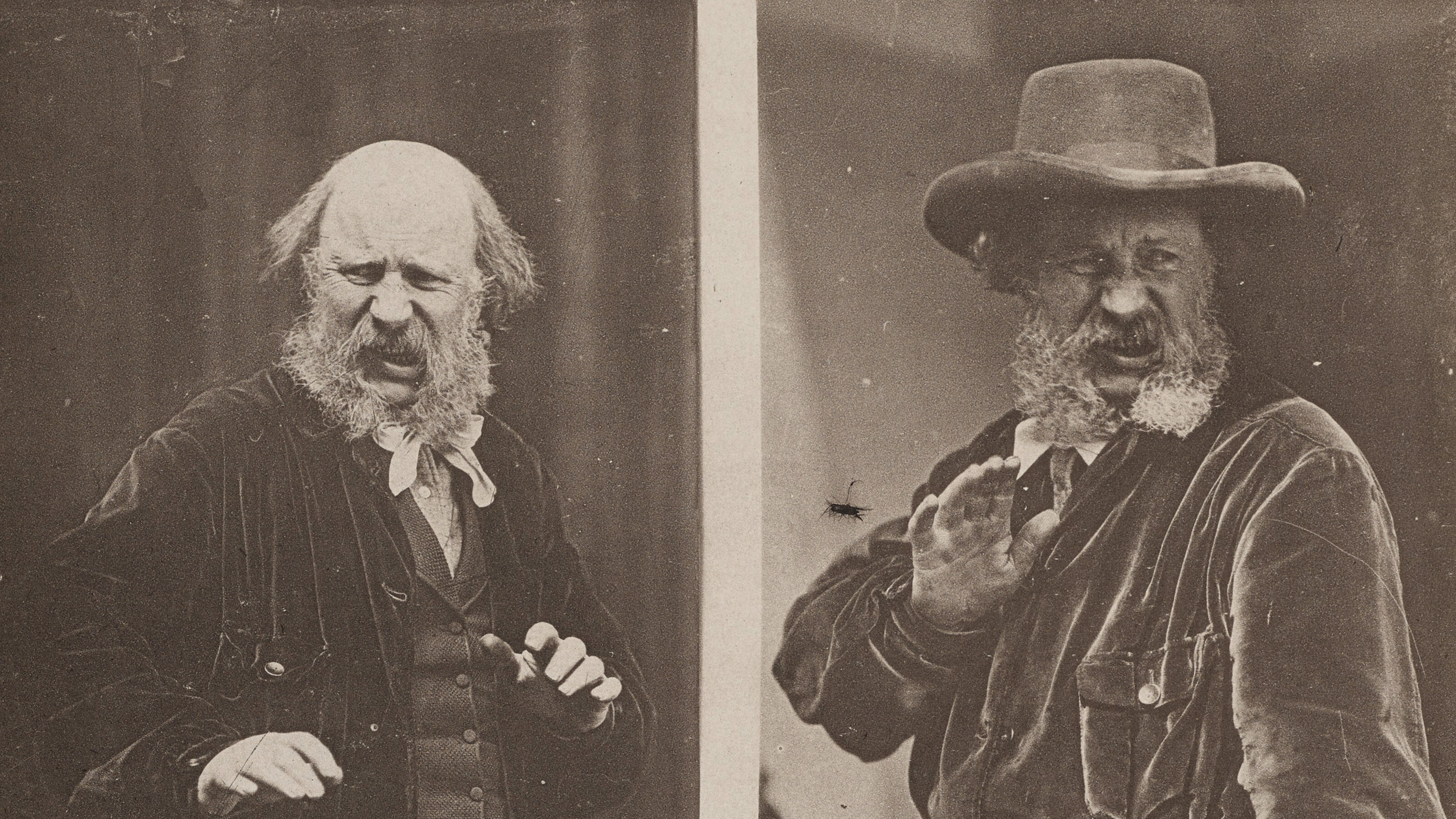

Hace poco, fui a la biblioteca pública, uno de mis lugares favoritos de Nueva York, para ver los cientos de cartas, escritos y reflexiones originales de Charles Darwin. Al famoso científico inglés le encantaba escribir, y su curiosidad y capacidad de observación cobran vida en las páginas.

Además de proponer la teoría de la evolución, Darwin estudió las expresiones y emociones tanto de personas como de animales. Debatió en sus escritos hasta qué punto las emociones son científicas, universales y predecibles; e incluso dibujó personajes con expresiones exageradas, expuestos en la biblioteca.

El tema sacudió algo dentro de mí.

Cuando todo el mundo se ha alzado en armas contra ChatGPT, la IA generalizada y la perspectiva de que los robots ocupen los puestos de trabajo de las personas, me di cuenta de que los reguladores han aumentado las advertencias contra la IA y el reconocimiento de emociones.

En este contexto tan alejado de Darwin, el reconocimiento de las emociones es el intento de identificar los sentimientos o el estado de ánimo de una persona mediante el análisis por IA de imágenes faciales, grabaciones de vídeo, o audio.

La idea no es complicada. El modelo de IA puede ver una boca abierta, ojos entrecerrados y mejillas contraídas con la cabeza echada hacia atrás, por ejemplo, y registrar una risa. Por tanto, concluye que el sujeto está contento.

Sin embargo, en la práctica, esto es más complejo. Y, según algunos, es un ejemplo peligroso e invasivo del tipo de pseudociencia que suele producir la inteligencia artificial.

Algunos defensores de la privacidad y los derechos humanos, como European Digital Rights (EDRi, por sus siglas en inglés) y Access Now, exigen una prohibición total del reconocimiento de emociones. La Ley de Inteligencia Artificial de la UE, aprobada por el Parlamento Europeo en junio, no es una prohibición total, aunque prohíbe el uso del reconocimiento de emociones por parte de los cuerpos de seguridad en la policía, la gestión de fronteras, los lugares de trabajo y los colegios.

Mientras tanto, algunos legisladores de EE UU también se han referido a este tema, y puede ser un punto clave en cualquier futura regulación de la IA. El senador Ron Wyden, uno de los legisladores que lideran la iniciativa, elogió a la UE por abordar esta cuestión. "Tus expresiones faciales, movimientos oculares, tono de voz y manera de caminar son formas terribles de juzgar quién eres o qué harás en el futuro”, advirtió Wyden. "Sin embargo, se están invirtiendo millones y millones de dólares en el desarrollo de una IA que detecte emociones basadas en una ciencia falsa".

No obstante, ¿por qué preocupa tanto? ¿Hasta qué punto los temores sobre el reconocimiento de las emociones están fundados, y una estricta regulación podría perjudicar la innovación positiva?

Un grupo de empresas ya están vendiendo esta tecnología para una amplia variedad de usos, aunque todavía no está muy extendida. Por ejemplo, Affectiva ha explorado cómo esta IA, que analiza las expresiones faciales humanas, podría utilizarse para determinar si un conductor está cansado y evaluar cómo reaccionan los espectadores ante el tráiler de una película. Otras empresas, como HireVue, han vendido el reconocimiento de las emociones como una forma de seleccionar a los candidatos más prometedores para un trabajo. Una práctica que ha recibido duras críticas.

"Estoy a favor de permitir que el sector privado desarrolle esta tecnología. Hay aplicaciones importantes, como permitir que las personas ciegas o con baja visión comprendan mejor las emociones de quienes les rodean", respondió por correo Daniel Castro, vicepresidente de la Information Technology and Innovation Foundation (ITIF, por sus siglas en inglés), un think tank con sede en Washington.

Sin embargo, otras aplicaciones de esta tecnología son más alarmantes. Por ejemplo, varias empresas han vendido a las fuerzas de seguridad algunos programas informáticos que averiguan si alguien miente, o pueden detectar comportamientos sospechosos.

iBorderCtrl, un proyecto piloto patrocinado por la Unión Europea, brinda una versión de reconocimiento de emociones como parte de su oferta tecnológica de gestión de fronteras. Según su web, el Sistema Automático de Detección del Engaño "cuantifica la probabilidad de engaño en las entrevistas analizando los microgestos no verbales de los entrevistados". Aunque reconoce la "controversia científica en torno a su eficacia".

El uso (o abuso, en este caso) más notorio de la tecnología de reconocimiento de emociones procede de China y, sin duda, está en el punto de mira de los legisladores.

El país ha utilizado la IA de emociones para la vigilancia, sobre todo, para controlar a la población uigur de Xinjiang, según un ingeniero de software que afirmó haber instalado estos sistemas en las comisarías de policía. El reconocimiento de emociones pretendía identificar un estado de ánimo nervioso o ansioso, una especie detector de mentiras. Como advirtió a la BBC un defensor de los derechos humanos, "se trata de personas que se encuentran en circunstancias muy coercitivas, bajo una gran presión, que están nerviosas, y se toma como indicio de culpabilidad". Algunas escuelas del país también han utilizado la tecnología con alumnos para medir la comprensión y el rendimiento.

Ella Jakubowska, asesora política de European Digital Rights, que tiene sede en Bruselas, aún no ha oído hablar de "ningún caso de uso creíble" para el reconocimiento de emociones. "Ambos [el reconocimiento facial y de emociones] tienen que ver con el control social; quién vigila y quién es vigilado; dónde vemos una concentración de poder".

Es más, hay pruebas de que los modelos de reconocimiento de emociones no pueden ser exactos. Las emociones son complicadas, e incluso los seres humanos no pueden identificarlas en los demás. Aunque la tecnología ha mejorado en los últimos años gracias a la disponibilidad de más y mejores datos, así como el aumento de la potencia informática, la precisión varía mucho en función de los resultados que persigue el sistema y la calidad de los datos que utiliza.

"La tecnología no es perfecta, aunque eso tenga menos que ver con los límites de la visión por ordenador y más con el hecho de que las emociones humanas son complejas, varían en función de la cultura y el contexto, y son imprecisas", aseguró Castro.

Esto lleva de nuevo a Darwin. Una pregunta fundamental en este campo es si la ciencia puede llegar a determinar las emociones. Puede que veamos avances en la computación afectiva a medida que progrese la ciencia subyacente de las emociones, o puede que no.

Se asemeja a una parábola para este amplio momento de la IA. La tecnología se encuentra en un periodo de gran expectación, y la idea de que la IA puede hacer que el mundo sea más reconocible y predecible puede resultar atractiva. Sin embargo, como se ha preguntado Meredith Broussard, la experta en IA, ¿puede reducirse todo a un problema matemático?