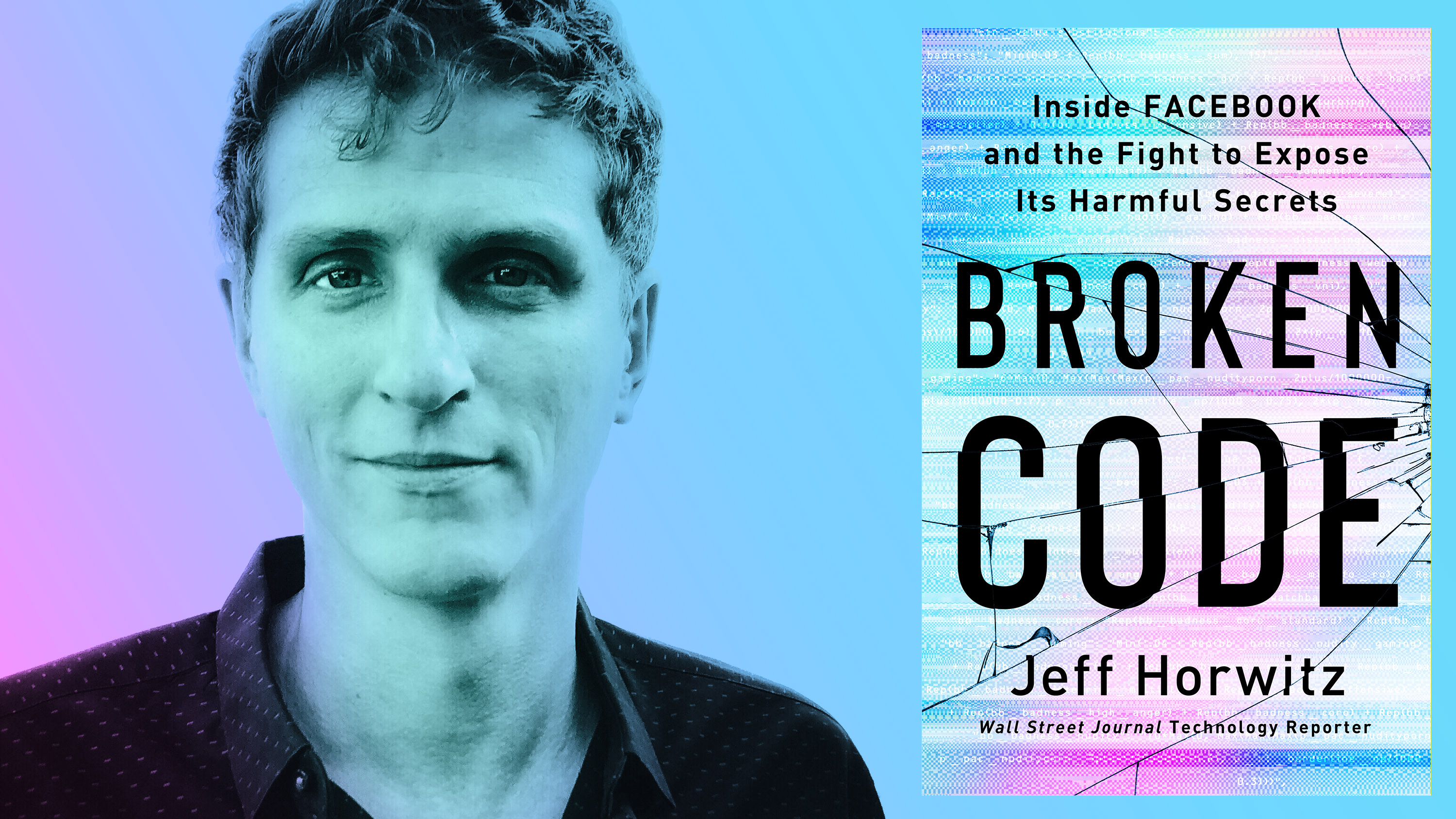

En un extracto de ‘Broken Code: Inside Facebook and the Fight to Expose its Harmful Secrets’, Jeff Horwitz revela cómo Facebook llegó a confiar en la inteligencia artificial

El siguiente extracto pertenece a Broken Code: Inside Facebook and the Fight to Expose its Harmful Secrets de Jeff Horwitz, que ha sido reimpreso con permiso de Doubleday. Una impresión de The Knopf Doubleday Publishing Group, una división de Penguin Random House LLC. Copyright © 2023 Jeff Horwitz.

En 2006, la oficina de patentes de EE UU recibió una solicitud para "una página generada de manera automática que contiene información relevante para un usuario sobre otro usuario de una red social". En lugar de obligar a las personas a buscar información interesante en contenidos "dispares y desorganizados", el sistema generaría una lista de información "relevante" en "orden de preferencia".

Los autores de la petición eran "Zuckerberg et al." y el producto era News Feed.

La idea de mostrar flujos de actividad a los usuarios no era nueva -Flickr, la web para compartir fotos, y otras ya habían experimentado con ella-, pero el cambio fue enorme. Antes, los usuarios de Facebook interactuaban a través de notificaciones, pokes (zumbidos) o consultando los perfiles de sus amigos. Con el lanzamiento del News Feed, los usuarios obtuvieron un flujo constantemente actualizado de publicaciones y cambios de estado. El cambio supuso un shock para los 10 millones de usuarios de Facebook de entonces, que no veían con buenos ojos que se vigilaran sus actividades y se buscara contenido actualizado en sus perfiles, hasta entonces estáticos. Ante las quejas generalizadas, Zuckerberg escribió un post tranquilizador: "Nada de lo que haces se difunde, sino que se comparte con personas a las que les importa lo que haces: tus amigos". Lo tituló "Calma. Respira. Te escuchamos".

Sin embargo, oír las quejas de los usuarios no era lo mismo que escucharlas. Como Chris Cox señaló más tarde en un evento para la prensa prensa, News Feed fue un éxito instantáneo a la hora de impulsar la actividad en la plataforma y conectar a los usuarios. El engagement se duplicó rápidamente, y a las dos semanas de su lanzamiento más de un millón de miembros se habían afiliado a un tema de interés por primera vez. ¿Qué había unido a tanta gente? La petición para erradicar el stalkeo de News Feed.

En retrospectiva, el sistema opaco contra el que se rebelaron los usuarios era muy sencillo. La mayoría de los contenidos aparecían en orden cronológico inverso, con ajustes manuales para garantizar que los usuarios vieran tanto las publicaciones más populares como material variado. "Al principio, la clasificación de News Feed consistía en girar mandos", explica Cox.

Juguetear con los mandos funcionó bien durante un tiempo, pero las listas de amigos de todos los usuarios crecían y Facebook introducía nuevas funciones como anuncios, páginas y grupos de interés. A medida que el entretenimiento, los memes y el comercio empezaban a competir con las publicaciones de amigos en la sección de noticias, Facebook necesitaba asegurarse de que un usuario que acababa de entrar viera las fotos del compromiso de boda de su mejor amigo antes que la popular receta de enchiladas de una página de cocina.

EdgeRank fue el primer intento de clasificación, consistía en una sencilla fórmula que priorizaba los contenidos en función de tres factores principales: la antigüedad de la publicación, el grado de participación, y la interconexión entre el usuario y la publicación. Como algoritmo, no era gran cosa, solo un intento aproximado de traducir a matemáticas las preguntas "¿es nuevo, popular o de alguien que te importa?".

No era magia negra, pero los usuarios volvieron a rebelarse contra la idea de que Facebook metiera el dedo en lo que veían. De nuevo, las métricas de uso de Facebook se dispararon en todos los ámbitos.

Los sistemas de recomendación de la plataforma aún estaban en pañales, pero la disonancia entre la aparente desaprobación de los usuarios y su ávido uso llevó a una conclusión ineludible dentro de la empresa: lo mejor era ignorar las opiniones de la gente corriente sobre la mecánica de Facebook. Los usuarios gritaban "basta", Facebook seguía adelante y todo funcionaba de maravilla.

En 2010, la empresa quería ir más allá de la rudimentaria fórmula de EdgeRank para recomendar contenidos basándose en el aprendizaje automático, una rama de la inteligencia artificial centrada en entrenar a los ordenadores para que diseñen sus propios algoritmos de toma de decisiones. Los ingenieros no programaron los ordenadores de Facebook para clasificar los contenidos según cálculos matemáticos simples, sino para analizar el comportamiento de los usuarios y diseñar sus propias fórmulas de clasificación. El público vería el resultado de una experimentación constante y la plataforma mostraría lo que, según las predicciones, tenía más probabilidades de generar un me gusta de un usuario. Luego, evaluaría sus propios resultados en tiempo real.

A pesar de la creciente complejidad de su producto y de la recopilación de datos de usuarios a una escala nunca vista en el mundo, Facebook seguía sin saber lo suficiente sobre sus usuarios como para mostrarles anuncios relevantes. A las marcas les encantaba la atención y la repercusión que podían obtener creando contenidos en Facebook, pero las ofertas de pago de la empresa no resultaban atractivas. En mayo de 2012, General Motors eliminó todo su presupuesto de publicidad en Facebook. Un destacado ejecutivo de publicidad digital declaró que los anuncios de Facebook eran "unas de las unidades publicitarias con peor rendimiento de la web".

La solución del problema recaería en un equipo dirigido por Joaquín Quiñonero Candela, un español criado en Marruecos. Quiñonero vivía en Reino Unido y en 2011 estaba trabajando en IA en Microsoft cuando varios amigos dispersos por el norte de África empezaron a hablar de las protestas impulsadas por las redes sociales. Las técnicas de aprendizaje automático que utilizaba para optimizar los anuncios de búsqueda de Bing tenían aplicaciones concretas en las redes sociales, los usuarios las estaban utilizando para derrocar a cuatro estados autocráticos y casi conseguirlo con otros tantos. "Me uní a Facebook a raíz de la Primavera Árabe", recuerda el programador.

Quiñonero descubrió que la forma en que Facebook construía sus productos era casi tan revolucionaria como sus resultados. Un amigo le invitó a visitar el campus de Menlo Park (California, EE UU), y se sorprendió al otear cómo un ingeniero realizaba una importante actualización sin supervisión del código de Facebook. Una semana más tarde, Quiñonero recibió una oferta de trabajo en Facebook, y eso confirmó la rapidez con la que la empresa se movía con respecto a Microsoft. Quiñonero empezó a trabajar en anuncios, y no pudo llegar en mejor momento. Los avances en el aprendizaje automático y la velocidad de cálculo permitieron a la plataforma no solo encasillar a los usuarios en nichos demográficos ("mujer heterosexual de San Francisco, veinteañera y soltera, interesada en la acampada y bailar salsa"), sino detectar correlaciones entre las publicaciones en las que clicaban para utilizar esa información y adivinar qué anuncios les parecerían relevantes. Tras empezar con conjeturas casi aleatorias sobre cómo maximizar las probabilidades de clics, el sistema aprendía de sus aciertos y errores, y perfeccionó su modelo para predecir qué anuncios tenían más posibilidades de éxito. No era un sistema omnisciente, los anuncios recomendados a menudo eran inexplicables, pero el listón de éxito en la publicidad digital era bajo: si el 2% de los usuarios hacían clic en un anuncio, era un triunfo. Con miles de millones de anuncios visualizados cada día, incluso los ajustes de algoritmo que producían ganancias modestas podían reportar decenas o cientos de millones de dólares en ingresos. El equipo de Quiñonero descubrió que podía producir esas alteraciones: "Le dije a mi equipo que fuera rápido e hiciera envíos semanales".

Ese ritmo veloz tenía sentido. La IA del equipo mejoraba no solo los ingresos, sino también la percepción de los usuarios sobre la plataforma. Unos anuncios mejor orientados significaban que Facebook podía ganar más dinero por usuario sin aumentar la carga publicitaria, y no había mucho que pudiera salir mal. Cuando Facebook lanzó cremas dentífricas a los adolescentes, nadie murió.

La publicidad fue la punta de lanza del aprendizaje automático en Facebook, y pronto todo el mundo quiso participar. Para los ejecutivos de producto encargados de aumentar el número de grupos de Facebook, los amigos y las publicaciones, el atractivo era obvio. Si las técnicas de Quiñonero podían aumentar la frecuencia con la que los usuarios interactuaban con los anuncios, también podrían aumentar la frecuencia con la que los usuarios interactuaban con todo lo demás en la plataforma.

Todos los equipos responsables de clasificar o recomendar contenidos se apresuraron a revisar sus sistemas tan rápido como pudieron, lo que provocó una explosión de la complejidad del producto de Facebook. Los empleados se dieron cuenta de que los mayores beneficios no procedían de iniciativas deliberadas, sino de pruebas simples. En lugar de rediseñar algoritmos, lo cual era lento, los ingenieros conseguían grandes resultados con experimentos rápidos y sucios de aprendizaje automático. Estos consistían en lanzar cientos de variantes de algoritmos existentes a la pared para ver qué versiones se quedaban y cuáles funcionaban mejor con el público. Por ejemplo, no sabían por qué una variable era importante o cómo un algoritmo superaba a otro en la predicción de la probabilidad de comentarios. Pero podrían seguir jugando hasta que el modelo de aprendizaje automático produjera un algoritmo que superara estadísticamente al existente entonces, y eso sería suficiente.

Es difícil concebir un enfoque de la construcción de sistemas que encarne mejor el lema "muévete rápido y rompe cosas". Facebook solo quería más y más. Zuckerberg cortejó a Yann LeCun, un informático francés especializado en aprendizaje profundo, para la construcción de sistemas tecnológicos capaces de procesar información de formas inspiradas en el pensamiento humano. LeCun, que ya era conocido por crear las técnicas fundamentales de la IA que posibilitaron el reconocimiento facial, fue puesto al frente de una división que pretendía situar a Facebook a la vanguardia de la investigación fundamental en IA.

Tras su éxito con los anuncios, a Quiñonero le encomendaron una tarea igual de formidable: introducir el aprendizaje automático en el torrente sanguíneo de la empresa lo más rápido posible. En los tres años transcurridos desde su contratación, había crecido su plantilla inicial de dos docenas de personas: el equipo responsable de crear nuevas herramientas básicas de aprendizaje automático y ponerlas a disposición de otras partes de la empresa. Pero seguía sin ser tan grande como para ayudar a todos los equipos de producto que lo necesitaran. Los conocimientos necesarios para crear un modelo desde cero eran demasiado especializados para que los ingenieros pudieran adquirirlos con facilidad, y no podía aumentarse la oferta de doctores en aprendizaje automático tirando el dinero.

La solución fue crear FB Learner, una especie de versión "paso a paso" del aprendizaje automático. Este empaquetó las técnicas en una plantilla que podían utilizar los ingenieros que no entendían lo que estaban haciendo. FB Learner hizo por el aprendizaje automático dentro de Facebook lo que servicios como WordPress hicieron por la creación de webs con anterioridad, siendo innecesario el uso de HTML o la configuración de un servidor. Sin embargo, en lugar de crear un blog, los ingenieros trasteaban las tripas de lo que rápidamente se estaba convirtiendo en una plataforma de comunicación global.

Muchos profesionales en Facebook eran conscientes de las crecientes preocupaciones en torno a la IA fuera de los muros de la empresa. Por ejemplo, algoritmos mal diseñados para recompensar la buena atención sanitaria penalizaban a los hospitales que trataban a pacientes más enfermos, y modelos que pretendían cuantificar el riesgo de reincidencia de un candidato a la libertad condicional estaban sesgados a favor de mantener a los afroamericanos en la cárcel. Pero estos problemas parecían remotos en una red social.

Más tarde, un ávido usuario de FB Learner describiría aquella difusión masiva del aprendizaje automático dentro de Facebook como "dar lanzacohetes a ingenieros de veinticinco años". Pero en aquel momento, Quiñonero y la empresa hablaron de ello como un triunfo.

"Los ingenieros y equipos, incluso con poca experiencia, pueden construir y ejecutar experimentos con facilidad y desplegar productos impulsados por IA más rápido que nunca", anunció Facebook en 2016, presumiendo de que FB Learner ingería diariamente billones de datos sobre el comportamiento de los usuarios y que los ingenieros ejecutaban 500.000 experimentos con ellos cada mes.

La ingente cantidad de datos que recopilaba Facebook y los resultados de la segmentación publicitaria, tan buenos que los usuarios sospechaban a menudo (de manera errónea) que la empresa espiaba sus conversaciones offline, dieron lugar a la afirmación de que "Facebook lo sabe todo sobre ti".

Eso no era del todo cierto. Las maravillas del aprendizaje automático no habían revelado sus límites. Los sistemas de recomendación de Facebook no identificaban sus gustos e intereses y servía contenidos en función de ellos, sino que funcionaba por correlación bruta sobre el comportamiento del usuario. News Feed no podía decir si a un usuario le gustaba el patinaje sobre hielo o el ciclismo de montaña, el hip-hop o el K- pop, tampoco podía explicar en términos humanos por qué un post aparecía en el feed por encima de otro. Aunque esta inexplicabilidad era un inconveniente obvio, los sistemas de recomendación basados en el aprendizaje automático reflejaban la profunda fe de Zuckerberg en los datos, el código y la personalización. En su opinión, liberados de las limitaciones, así como los errores y prejuicios humanos, los algoritmos de Facebook eran capaces de una objetividad sin parangón y, lo más importante, de una eficacia sin parangón.

Otro tipo de trabajo de aprendizaje automático se dedicó a averiguar qué contenido había en realidad en las publicaciones recomendadas por Facebook. Los clasificadores eran sistemas de IA entrenados para reconocer patrones en grandes conjuntos de datos. Años antes de la creación de Facebook, los clasificadores habían demostrado ser indispensables en la lucha contra el spam, pues permitieron a los proveedores de correo electrónico ir más allá de los simples filtros de palabras clave que bloqueaban los correos masivos sobre, por ejemplo, la "Vi@gra". Al ingerir y comparar una gran colección de correos electrónicos -algunos etiquetados como spam, y otros no-, un sistema de aprendizaje automático podía desarrollar su propia rúbrica para distinguirlos. Una vez "entrenado", el clasificador se pondría en marcha para analizar el correo entrante y predecir la probabilidad de que cada mensaje se envíe a la bandeja de entrada, la carpeta de correo no deseado o al infierno por la vía rápida.

Cuando los expertos en aprendizaje automático empezaron a aterrizar en Facebook, la lista de preguntas que los clasificadores trataban de responder había crecido más allá de "¿Esto es spam?", gracias en gran medida a personas como LeCun. Zuckerberg era optimista sobre su futuro progreso y sus aplicaciones para Facebook. En 2016, predijo que en los próximos cinco a diez años los clasificadores superarían las capacidades humanas de percepción, reconocimiento y comprensión. Esto permitiría a la empresa acabar con el mal comportamiento y dar pasos de gigante para conectar el mundo, una predicción que resultó ser más que optimista.

Aunque las técnicas mejoraron, los conjuntos de datos aumentaron y el procesamiento se aceleró, también persistió un inconveniente del aprendizaje automático. La empresa producía unos algoritmos que se negaban a explicarse. Los ingenieros podían evaluar el éxito de un clasificador probándolo para ver qué porcentaje de sus juicios eran acertados (su "precisión") y qué parte de una cosa detectaba (su "recuerdo"). Como el sistema se enseñaba a sí mismo a identificar algo basándose en una lógica diseñada por él mismo, cuando se equivocaba no había ninguna razón reconocible para el ser humano.

A veces los errores parecían absurdos, otras veces eran sistemáticos y reflejaban errores humanos. Arturo Bejar recuerda que, al inicio de los esfuerzos de Facebook por desplegar un clasificador para detectar pornografía, el sistema intentaba seleccionar imágenes de camas. En lugar de aprender a identificar a personas teniendo sexo, el modelo se había enseñado a sí mismo a reconocer los muebles donde se practicaba con más frecuencia.

El problema tenía fácil solución: los ingenieros solo tenían que entrenar el modelo con más escenas con colchones para adultos. Era un buen chiste, siempre que no se tuviera en cuenta que la forma de aprendizaje automático que los ingenieros acababan de estropear era una de las más básicas que Facebook utilizaba. Continuaron produciéndose errores fundamentales similares, incluso cuando la empresa pasó a confiar en técnicas de IA más avanzadas para tomar decisiones más importantes y complejas que "porno, no porno". La empresa apostaba por la IA, tanto para determinar lo que los usuarios deberían ver como para resolver cualquier problema que pudiera surgir.

Sin duda, la informática era deslumbrante y los beneficios muy concretos. Pero la velocidad, la amplitud y la escala de la adopción del aprendizaje automático por parte de Facebook se produjo a costa de la comprensibilidad. ¿Por qué el algoritmo "Páginas que te pueden gustar" de Facebook parecía tan centrado en recomendar determinados temas? ¿Cómo un fragmento de vídeo de una animación por ordenador sobre implantes dentales había acabado siendo visto cien millones de veces? ¿Y por qué algunos editores de noticias lograron la viralidad de manera sistemática cuando se limitaban a reescribir las historias de otros medios?

Ante estas preguntas, el equipo de comunicación de Facebook señalaba que los sistemas de la empresa respondían al comportamiento de las personas y que no se tenían en cuenta los gustos. Eran argumentos difíciles de rebatir, y ocultaban un hecho incómodo: Facebook estaba logrando su crecimiento de formas que no comprendía del todo.

Tras cinco años utilizando el aprendizaje automático para recomendar contenidos y orientar anuncios, los sistemas de Facebook dependían tanto de la IA que se entrenaba a sí misma que, sin esa tecnología, todo lo que quedaría de los productos de la empresa sería "polvo", según afirmó Yann LeCun con orgullo.