La empresa de Silicon Valley quiere mejorara la inteligencia artificial haciendo que se parezca lo más posible a la nuestra

La inteligencia artificial (IA) es un campo que está experimentando rápidos y emocionantes cambios. En gran parte se debe a un improvisado entendimiento de cómo funcionan las redes neuronales y la creación de grandes bases de datos para entrenarlas. El resultado son máquinas que de repente están mucho mejor capacitadas para cosas como el reconocimiento de caras y objetos, tareas en las que casi siempre han disfrutado los humanos de una importante ventaja (ver El hombre que enseña a las máquinas a entender el lenguaje).

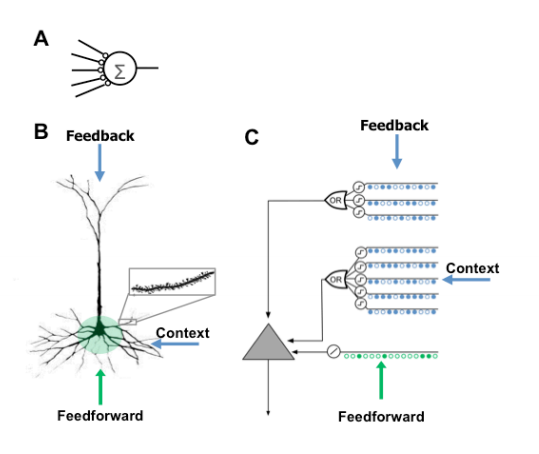

Pero existe un rompecabezas en el corazón de estos avances. Aunque las redes neuronales están claramente inspiradas en el funcionamiento del cerebro humano, las neuronas artificiales que contienen no se parecen en nada a las que trabajan dentro de nuestro propio wetware (NdlT: término inglés que se refiere a la computación de hardware y software, pero aplicado a sistemas biológicos). Las neuronas artificiales, por ejemplo, generalmente solo tienen un puñado de sinapsis y carecen por completo de las cortas terminaciones nerviosas ramificadas conocidas como dendritas y las miles de sinapsis que se forman entre ellas. De hecho, nadie sabe por qué las neuronas biológicas disponen de tantas sinapsis.

Hoy, esto cambia gracias al trabajo de Jeff Hawkins y Subutai Ahman de Numenta, una start-up de Silicon Valley (EEUU) centrada en entender y aprovechar los principios subyacentes del procesamiento de informaciones biológicas. Los avances de este equipo han dado paso a una nueva teoría que por fin explica el papel de la vasta cantidad de sinapsis de las neuronas reales y un modelo basado en esta teoría que reproduce muchos de los comportamientos inteligentes de las neuronas reales.

Las neuronas biológicas tienen un cuerpo de célula, conocido como el soma, que contiene el núcleo de la célula y del cual se extienden varias dendritas proximales, además del axón, una fina proyección como un cable que se puede alargar durante muchos centímetros y conectar con otras neuronas. Al final del axón hay otro conjunto de ramas, conocidas como dentritas distales por la distancia que las separa del soma.

Las dentritas proximales y distales forman miles de conexiones, llamadas sinapsis, con los axones de otras células nerviosas. Estas conexiones influencian el ritmo al cual las células nerviosas producen una señal eléctrica al que nos referimos como impulsos nerviosos.

El consenso es que las neuronas "aprenden" al reconocer determinados patrones de conexiones entre las sinapsis y se disparan cuando observan este patrón.

Aunque es fácil entender la influencia de las sinapsis próximas en el cuerpo de la célula y el ritmo de disparos, resulta difícil comprender cómo las espinas dentríticas pueden hacer lo mismo, desde tanta distancia respecto al soma.

Hawkins y Ahmad afirman saber qué pasa. Su concepto nuevo es que las sinapsis distales y proximales desempeñan labores completamente distintas dentro del proceso de aprendizaje. Las sinapsis proximales juegan el papel convencional de provocar que la célula se dispare cuando se presenten determinados patrones de conexiones.

Esto es el proceso convencional del aprendizaje. "Demostramos que una neurona puede reconocer cientos de patrones incluso en presencia de grandes cantidades de ruido y variabilidad mientras que la actividad neuronal general sea escasa", dicen Hawkins y Ahmad.

Pero las sinapsis distales hacen otra cosa. También reconocen la presencia de determinados patrones, pero no provocan que la célula se dispare. En lugar de ello, influyen el estado eléctrico de la célula para facilitar el disparo si después se presenta otro patrón determinado. O, como lo explican Hawkins y Ahmad, estas sinapsis ayudan a la célula a predecir cuál será el siguiente patrón observado por la sinapsis proximal.

Es enormemente importante. Significa que además de aprender cuándo se presenta un patrón determinado, la célula también aprende la secuencia en la que se presentan los patrones. Los investigadores afirman: "Demostramos cómo una red de neuronas con esta propiedad aprenderá y recordará la secuencia de patrones".

Es más, demuestran que todo esto funciona bien, incluso en presencia de gran cantidad de ruido, como es el caso de los sistemas biológicos.

Es una nueva e importante manera de considerar las neuronas y reproduce algunas de las características clave del procesamiento de información del cerebro humano. Por ejemplo, Hawkins y Ahmad demuestran que este sistema no recuerda cada detalle de cada patrón de una secuencia, en lugar de eso, almacena la diferencia entre un patrón y el siguiente.

Así que lo que importa no es la cantidad total de información dentro de un patrón, sino la diferencia entre este patrón y el siguiente.

Es una interesante propiedad que puede ayudar a explicar otra característica misteriosa de la memoria humana llamada chunking (término del inglés que describe la descomposición de la memoria en trozos). Esta es la observación de que, por media, los humanos pueden almacenar unos siete "trozos" de información en su memoria de trabajo. Estos trozos pueden ser cosas como dígitos, letras o incluso palabras, pero sean lo que sean, los humanos sólo pueden recordar unos siete (con un margen de error de uno o dos).

Pero, el contenido de una sola palabra, como "sinapsis", es significativamente más grande que el contenido de un solo dígito, como un "7". El rompecabezas consiste en que nadie sabe cómo el cerebro consigue retener la información contenida en siete palabras con la misma facilidad que retiene siete dígitos.

Pero según el modelo Nuevo de Hawkins y Ahmad, este problema desaparece. El cerebro no almacena la información relacionada con la palabra o el dígito, sólo la diferencia entre ellos, que puede ser mucho menor. Eso debería dar paso a algunas hipótesis comprobables acerca de la naturaleza de la memoria.

El nuevo modelo conduce a otras hipótesis comprobables también. Por ejemplo, el modelo solo funciona cuando existen pocas sinapsis entre el axón de una neurona y la dendrita de otra. Si existiesen demasiadas sinapsis, no sería posible distinguir un patrón de otro y todos los patrones se parecerían entre ellos.

Si el modelo de Hawkins y Ahmad es correcto, esto no puede suceder en neuronas reales. "Para prevenir que esto pase, prevemos la existencia de un mecanismo que impide activamente la formación de múltiples sinapsis después de haberse establecido alguna", dicen.

Es algo poco común en la biología - una hipótesis comprobable. Pero es algo que sin duda proporciona a los neurocientíficos algo que buscar con sus lupas.

Finalmente, otro aspecto digno de mencionar es que esta nueva teoría no nace de un entorno académico sino de una start-up de Silicon Valley. Esta empresa nació de Jeff Hawkins, un emprendedor, inventor y neurocientífico. Hawkins inventó el Palm Pilot en la década de 1990, y desde entonces se ha dedicado a la neurociencia a tiempo completo.

Es una mezcla singular de experiencia que hace que sea altamente probable que observemos a estas nuevas neuronas artificiales aplicadas a problemas del mundo real en un futuro no muy lejano. Por cierto, Hawkins y Ahmad llaman a sus nuevos juguetes neuronas de Memoria Temporal Jerárquicas, o neuronas HTM (por sus siglas en inglés). Prepárate para escuchar mucho más acerca de ellas.

Ref: arxiv.org/abs/1511.00083: Why Neurons Have Thousands of Synapses, A Theory of Sequence Memory in Neocortex